How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Nota: This feature may not be available in some browsers.

Stai usando un browser molto obsoleto. Puoi incorrere in problemi di visualizzazione di questo e altri siti oltre che in problemi di sicurezza. .

Dovresti aggiornarlo oppure usare usarne uno alternativo, moderno e sicuro.

Dovresti aggiornarlo oppure usare usarne uno alternativo, moderno e sicuro.

Come funzionano le Venus ?

- Creatore Discussione SatuRno17

- Data di inizio

Per me viene spinta dalla ventilazione/movimentazione in maniera casuale e se entra nella bocca, viene rilevata da un sensore che né blocca la fuoriuscita facendola diventare "estratta".Viene aspirata...quando entra il flusso d'aria le palline vengono mescolate nel vortice e allorquando una pallina arriva ad una certa posizione specifica non so come stabilita, questa viene aspirata...

Ultima modifica:

SatuRno17

Super member

Breve conversazione con Chat GPT:

1a domanda:

Secondo te, coloro che gestiscono le macchine estrattrici, cambiano i parametri (velocità di flusso, tempo di mescolamento) ? Se si, cosa cambierebbe ?

Domanda molto interessante, e sì — in teoria i parametri delle macchine estrattrici potrebbero essere modificati (anche solo leggermente) da chi le gestisce. Vediamo cosa comporterebbe.

Meno tempo = possibilità che alcune palline si trovino più spesso nella “zona calda” dell’estrazione.

Dunque se i parametri non venissero cambiati, il gioco potrebbe risultare, anche se minimamente, prevedibile ?

Esatto — sì, teoricamente il gioco potrebbe diventare minimamente prevedibile, ma solo in senso probabilistico e solo nel lungo periodo. Facciamo un passo per volta.

Risultato? Un sistema pseudo-casuale, non perfettamente casuale.

Dove si manifesta questa non-casualità?

Allora sì: potresti simulare l’estrazione con una precisione quasi perfetta, come accade nei sistemi deterministici complessi (es. il biliardo o l'innaffiatoio caotico).

Ma poiché non puoi farlo, allora ti rimane l’osservazione dei risultati per tentare di risalire al meccanismo.

1a domanda:

Secondo te, coloro che gestiscono le macchine estrattrici, cambiano i parametri (velocità di flusso, tempo di mescolamento) ? Se si, cosa cambierebbe ?

Domanda molto interessante, e sì — in teoria i parametri delle macchine estrattrici potrebbero essere modificati (anche solo leggermente) da chi le gestisce. Vediamo cosa comporterebbe.

Quali sono i parametri variabili in un'estrazione?

Le macchine estrattrici del Lotto sono dispositivi meccanico-pneumatici, e i parametri principali su cui si potrebbe agire sono:- Velocità del flusso d’aria (pressione iniziale e finale)

- Durata della mescolazione prima dell’apertura della teca

- Angolazione o posizione della macchina

- Momento esatto in cui viene attivata l’estrazione

- Qualità e manutenzione dell'urna e delle palline

1.

- Cambia la turbolenza interna all’urna → impatti diversi → traiettorie diverse.

- Può influenzare quali palline tendono ad alzarsi più spesso, se il flusso ha un pattern ricorrente.

2.

Più tempo = maggiore caos → distribuzione più casuale.Meno tempo = possibilità che alcune palline si trovino più spesso nella “zona calda” dell’estrazione.

3.

- Influenza il punto di ricaduta delle palline e i rimbalzi.

- Anche una leggera inclinazione potrebbe favorire certi "pattern spaziali".

4.

- Se c’è un intervallo fisso tra attivazione e apertura, anche una variazione di pochi millisecondi potrebbe fare la differenza.

Dunque se i parametri non venissero cambiati, il gioco potrebbe risultare, anche se minimamente, prevedibile ?

Esatto — sì, teoricamente il gioco potrebbe diventare minimamente prevedibile, ma solo in senso probabilistico e solo nel lungo periodo. Facciamo un passo per volta.

Se i parametri non venissero mai cambiati:

- La macchina estrattrice opererebbe sempre nello stesso modo fisico.

- Le turbolenze, attriti, urti, flussi si comporterebbero con variazioni casuali, ma vincolate dallo stesso sistema.

- Le palline avrebbero sempre lo stesso peso, forma, elasticità, densità.

Risultato? Un sistema pseudo-casuale, non perfettamente casuale.

Dove si manifesta questa non-casualità?

- Frequenze leggermente più alte o più basse di alcuni numeri (bias).

- Ripetizioni statisticamente sospette in determinate ruote.

- Eventi che si manifestano con regolarità superiore al caso puro, come:

- Un numero che tende ad uscire dopo un altro (eventi concatenati).

- Combinazioni "sorelle" che si richiamano nel tempo.

- Ricorrenze legate a posizione nella cinquina (es. "il 58 esce spesso come terzo").

E se avessimo dati perfetti?

Se tu potessi:- Conoscere le condizioni esatte della macchina.

- Misurare ogni variabile fisica.

- Tracciare la posizione iniziale di ogni pallina.

Allora sì: potresti simulare l’estrazione con una precisione quasi perfetta, come accade nei sistemi deterministici complessi (es. il biliardo o l'innaffiatoio caotico).

Ma poiché non puoi farlo, allora ti rimane l’osservazione dei risultati per tentare di risalire al meccanismo.

Venuslotto

Super member

Mi piacerebbe intervenire su questo argomento su "L'aria che tira"

Dico la mia con argomenti diversi da come la penso io,anche un ignorante va preso e messo nel vaglio della discussione.

Esempio: Se prendiamo 5 auto uguali stessa cilindrata,stessa potenza,se gonfiamo le ruote a (2.5 quelle davanti e dietro) lo stesso giorno e lo stesso orario,

e dopo 5 giorni al mattino a ruote fredde,le controlliamo,si osserva l'auto numero 1, dietro 2.3 davanti 2.2 e le altre 4 auto rimangono a 2.5 ci sara' un perche' mi domando io. Lascio a voi il compressore.

Dico la mia con argomenti diversi da come la penso io,anche un ignorante va preso e messo nel vaglio della discussione.

Esempio: Se prendiamo 5 auto uguali stessa cilindrata,stessa potenza,se gonfiamo le ruote a (2.5 quelle davanti e dietro) lo stesso giorno e lo stesso orario,

e dopo 5 giorni al mattino a ruote fredde,le controlliamo,si osserva l'auto numero 1, dietro 2.3 davanti 2.2 e le altre 4 auto rimangono a 2.5 ci sara' un perche' mi domando io. Lascio a voi il compressore.

max63

Super member

Ciao SatuRno...ciao a tutti...La setssa domanda che avevo tempo fa posto io al IA....la conclusione incontrovertibile é l osssrvazzione dei risultati.

Ecco perche creare un modello di ML che permette di apprendere dai dati senza essere programmati esplicitamente. Invece di scrivere istruzioni precise, si forniscono al modello dati di esempio affinché possa riconoscere pattern e fare previsioni.

Quindi:

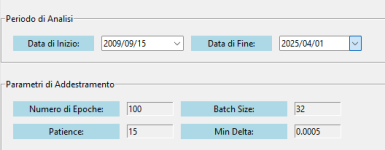

Raccolta dei Dati → Si raccolgono dati rilevanti e per rilevanti intendo dati estrazionali in questo caso dal 15/09/2009..Inizio venus

Preparazione dei Dati → Si puliscono e si organizzano i dati per il modello.

Scelta del Modello → Si seleziona un algoritmo adatto (es. rete neurale, decision tree, ecc.).

Addestramento → Il modello impara dai dati, cercando di ridurre l'errore.

Valutazione → Si testa il modello su dati nuovi per verificare la sua precisione.

Predizione → Il modello viene usato per fare previsioni su nuovi dati.

Come tempo fa in altra discussione se ne parlava.. Tipo di modello ( dence o LSTM) patience per l early stopping, epoche Min delta batch size ottmimizzatore Funzione di loss, Neuroni Dropout, Funzione di attivazione, regolarizzazzione ( L1 o L2), Rumore, sono fondamentali per l'addestramento del modello.

Allego la spiegazione di una delle mie configurazioni di machine Learning ed alcune immagini:

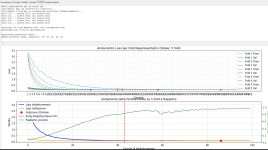

L'Indicatore Più Importante: La Loss di Validazione (Validation Loss)

Guarda la Curva Arancione (Loss Validazione): Questa curva mostra quanto bene il modello sta performando su dati che non ha usato per l'addestramento diretto in quell'epoca. È la misura più importante per capire se il modello sta generalizzando bene (cioè se sarà utile su dati nuovi, reali).

Trova il Punto Più Basso della Curva Arancione: Cerca il valore minimo (il punto più in basso sull'asse Y "Perdita") che la curva arancione raggiunge durante tutto l'addestramento.

Confrontare i Minimi tra le varie Esecuzioni:

Prendi il grafico della tua esecuzione precedente e trova il punto più basso della sua curva arancione.

Prendi il grafico della tua esecuzione attuale e trova il punto più basso della sua curva arancione.

Se il punto più basso della curva arancione nel grafico attuale è inferiore (più vicino allo zero sull'asse Y) rispetto a quello del grafico precedente, c'è stato un MIGLIORAMENTO.

Guarda il Valore Numerico Val Loss Media: Questo numero, riportato nel testo sopra i grafici, di solito corrisponde alla loss di validazione nel momento in cui l'addestramento si è fermato (o al valore minimo se è stata attivata l'opzione restore_best_weights). Confronta questo numero tra le diverse esecuzioni. Un numero più basso indica un miglioramento.

Esempio di varie elaborazioni:

Run 1: Val Loss Media = 0.0856

Run 2: Val Loss Media = 0.0850 (Miglioramento rispetto a Run 1)

Run 3: Val Loss Media = 0.0841 (Miglioramento marginale rispetto a Run 2) Quella dell ‘immagine

Cosa Ti Dicono le Altre Curve (Contesto):

Curva Blu (Loss Addestramento): Mostra quanto bene il modello impara sui dati di addestramento. Ci aspettiamo che scenda. Un valore molto basso qui, ma alto sulla curva arancione, indica overfitting.

Curva Verde (Rapporto Loss/Val): Mostra il rapporto tra la loss di addestramento e quella di validazione. Se sale molto, significa che il modello sta diventando molto bravo sui dati di training ma non altrettanto su quelli di validazione (un altro segno di overfitting). Idealmente, vorremmo che questo rapporto rimanesse il più basso possibile mentre la Loss di Validazione (arancione) è anch'essa bassa.

Linea Rossa (Early Stopping): Indica semplicemente quando l'addestramento si è fermato. Non dice direttamente se il modello è migliore o peggiore, ma solo per quante epoche ha girato prima di fermarsi.

Punto Rosso (Soluzione Ottimale): Indica il punto (epoca) in cui l'addestramento si è fermato e/o dove è stata trovata la migliore performance (minima loss di validazione) secondo i criteri dell'Early Stopping.

In Sintesi:

Per vedere se hai migliorato, concentrati sulla curva arancione (Loss Validazione) e sul valore numerico Val Loss Media. Cerca il valore più basso possibile per questi indicatori. Un valore più basso significa che il modello commette meno errori sui dati di validazione, e quindi ci si aspetta che generalizzi meglio.

Vedere la linea arancione così bassa e piatta può far pensare di aver raggiunto un limite. Ecco dove può (teoricamente e praticamente) arrivare e perché potrebbe non scendere oltre:

Limite Teorico (Zero): In un mondo perfetto, con dati perfetti e un modello perfetto, la loss (sia di addestramento che di validazione) potrebbe arrivare a zero. Questo significherebbe che il modello non commette alcun errore secondo la metrica di loss utilizzata.

Limite Pratico (Irriducibile Errore): Nella realtà, questo non accade quasi mai, specialmente con dati complessi o rumorosi come quelli delle serie temporali o delle estrazioni. Ci sono diversi motivi per cui la loss di validazione si ferma a un certo punto (come il tuo ~0.085) e non scende oltre:

Rumore Intrinseco nei Dati: I dati stessi contengono una componente casuale o "rumorosa" che è fondamentalmente imprevedibile. Nessun modello, per quanto buono, può prevedere il puro caso. La loss minima raggiungibile è limitata da questo "pavimento" di rumore. Per le estrazioni, questa componente casuale è molto alta.

Complessità Non Catturata: Il modello (la tua LSTM 256/128/64), pur essendo potente, potrebbe non avere la struttura o la capacità esatta per catturare tutti i pattern prevedibili presenti nei dati. Magari un'architettura diversa o più dati potrebbero fare leggermente meglio.

Qualità/Quantità dei Dati: Forse i dati disponibili non sono sufficienti o non contengono abbastanza informazioni "predittive" per permettere al modello di andare oltre quel livello di errore.

Feature Engineering: Le feature (le colonne di input che dai al modello) potrebbero non essere ottimali. Magari trasformando i dati o aggiungendo nuove feature derivate si potrebbe dare al modello più "appigli" per imparare.

Overfitting (anche lieve): Anche se la curva sembra piatta, è possibile che tentare di forzarla ancora più in basso porti il modello a imparare dettagli specifici del set di addestramento che non si generalizzano (overfitting), facendo risalire la loss di validazione. Il punto ~0.085 potrebbe essere il miglior compromesso tra apprendimento e generalizzazione per questo specifico setup.

Minimo Locale: L'algoritmo di ottimizzazione potrebbe essersi assestato in un "minimo locale" della funzione di loss, che è buono, ma non è il minimo globale assoluto (che potrebbe essere irraggiungibile comunque per i motivi sopra).

Ho dato in pasto dati dal 15/09/2009

Al momento su Bari non é sortito nulla ma c e stato l'ambo su Napoli...casualmente ruota del Sud..La venus é la stessa.

ciao a tutti

Ecco perche creare un modello di ML che permette di apprendere dai dati senza essere programmati esplicitamente. Invece di scrivere istruzioni precise, si forniscono al modello dati di esempio affinché possa riconoscere pattern e fare previsioni.

Quindi:

Raccolta dei Dati → Si raccolgono dati rilevanti e per rilevanti intendo dati estrazionali in questo caso dal 15/09/2009..Inizio venus

Preparazione dei Dati → Si puliscono e si organizzano i dati per il modello.

Scelta del Modello → Si seleziona un algoritmo adatto (es. rete neurale, decision tree, ecc.).

Addestramento → Il modello impara dai dati, cercando di ridurre l'errore.

Valutazione → Si testa il modello su dati nuovi per verificare la sua precisione.

Predizione → Il modello viene usato per fare previsioni su nuovi dati.

Come tempo fa in altra discussione se ne parlava.. Tipo di modello ( dence o LSTM) patience per l early stopping, epoche Min delta batch size ottmimizzatore Funzione di loss, Neuroni Dropout, Funzione di attivazione, regolarizzazzione ( L1 o L2), Rumore, sono fondamentali per l'addestramento del modello.

Allego la spiegazione di una delle mie configurazioni di machine Learning ed alcune immagini:

L'Indicatore Più Importante: La Loss di Validazione (Validation Loss)

Guarda la Curva Arancione (Loss Validazione): Questa curva mostra quanto bene il modello sta performando su dati che non ha usato per l'addestramento diretto in quell'epoca. È la misura più importante per capire se il modello sta generalizzando bene (cioè se sarà utile su dati nuovi, reali).

Trova il Punto Più Basso della Curva Arancione: Cerca il valore minimo (il punto più in basso sull'asse Y "Perdita") che la curva arancione raggiunge durante tutto l'addestramento.

Confrontare i Minimi tra le varie Esecuzioni:

Prendi il grafico della tua esecuzione precedente e trova il punto più basso della sua curva arancione.

Prendi il grafico della tua esecuzione attuale e trova il punto più basso della sua curva arancione.

Se il punto più basso della curva arancione nel grafico attuale è inferiore (più vicino allo zero sull'asse Y) rispetto a quello del grafico precedente, c'è stato un MIGLIORAMENTO.

Guarda il Valore Numerico Val Loss Media: Questo numero, riportato nel testo sopra i grafici, di solito corrisponde alla loss di validazione nel momento in cui l'addestramento si è fermato (o al valore minimo se è stata attivata l'opzione restore_best_weights). Confronta questo numero tra le diverse esecuzioni. Un numero più basso indica un miglioramento.

Esempio di varie elaborazioni:

Run 1: Val Loss Media = 0.0856

Run 2: Val Loss Media = 0.0850 (Miglioramento rispetto a Run 1)

Run 3: Val Loss Media = 0.0841 (Miglioramento marginale rispetto a Run 2) Quella dell ‘immagine

Cosa Ti Dicono le Altre Curve (Contesto):

Curva Blu (Loss Addestramento): Mostra quanto bene il modello impara sui dati di addestramento. Ci aspettiamo che scenda. Un valore molto basso qui, ma alto sulla curva arancione, indica overfitting.

Curva Verde (Rapporto Loss/Val): Mostra il rapporto tra la loss di addestramento e quella di validazione. Se sale molto, significa che il modello sta diventando molto bravo sui dati di training ma non altrettanto su quelli di validazione (un altro segno di overfitting). Idealmente, vorremmo che questo rapporto rimanesse il più basso possibile mentre la Loss di Validazione (arancione) è anch'essa bassa.

Linea Rossa (Early Stopping): Indica semplicemente quando l'addestramento si è fermato. Non dice direttamente se il modello è migliore o peggiore, ma solo per quante epoche ha girato prima di fermarsi.

Punto Rosso (Soluzione Ottimale): Indica il punto (epoca) in cui l'addestramento si è fermato e/o dove è stata trovata la migliore performance (minima loss di validazione) secondo i criteri dell'Early Stopping.

In Sintesi:

Per vedere se hai migliorato, concentrati sulla curva arancione (Loss Validazione) e sul valore numerico Val Loss Media. Cerca il valore più basso possibile per questi indicatori. Un valore più basso significa che il modello commette meno errori sui dati di validazione, e quindi ci si aspetta che generalizzi meglio.

Vedere la linea arancione così bassa e piatta può far pensare di aver raggiunto un limite. Ecco dove può (teoricamente e praticamente) arrivare e perché potrebbe non scendere oltre:

Limite Teorico (Zero): In un mondo perfetto, con dati perfetti e un modello perfetto, la loss (sia di addestramento che di validazione) potrebbe arrivare a zero. Questo significherebbe che il modello non commette alcun errore secondo la metrica di loss utilizzata.

Limite Pratico (Irriducibile Errore): Nella realtà, questo non accade quasi mai, specialmente con dati complessi o rumorosi come quelli delle serie temporali o delle estrazioni. Ci sono diversi motivi per cui la loss di validazione si ferma a un certo punto (come il tuo ~0.085) e non scende oltre:

Rumore Intrinseco nei Dati: I dati stessi contengono una componente casuale o "rumorosa" che è fondamentalmente imprevedibile. Nessun modello, per quanto buono, può prevedere il puro caso. La loss minima raggiungibile è limitata da questo "pavimento" di rumore. Per le estrazioni, questa componente casuale è molto alta.

Complessità Non Catturata: Il modello (la tua LSTM 256/128/64), pur essendo potente, potrebbe non avere la struttura o la capacità esatta per catturare tutti i pattern prevedibili presenti nei dati. Magari un'architettura diversa o più dati potrebbero fare leggermente meglio.

Qualità/Quantità dei Dati: Forse i dati disponibili non sono sufficienti o non contengono abbastanza informazioni "predittive" per permettere al modello di andare oltre quel livello di errore.

Feature Engineering: Le feature (le colonne di input che dai al modello) potrebbero non essere ottimali. Magari trasformando i dati o aggiungendo nuove feature derivate si potrebbe dare al modello più "appigli" per imparare.

Overfitting (anche lieve): Anche se la curva sembra piatta, è possibile che tentare di forzarla ancora più in basso porti il modello a imparare dettagli specifici del set di addestramento che non si generalizzano (overfitting), facendo risalire la loss di validazione. Il punto ~0.085 potrebbe essere il miglior compromesso tra apprendimento e generalizzazione per questo specifico setup.

Minimo Locale: L'algoritmo di ottimizzazione potrebbe essersi assestato in un "minimo locale" della funzione di loss, che è buono, ma non è il minimo globale assoluto (che potrebbe essere irraggiungibile comunque per i motivi sopra).

Ho dato in pasto dati dal 15/09/2009

Al momento su Bari non é sortito nulla ma c e stato l'ambo su Napoli...casualmente ruota del Sud..La venus é la stessa.

ciao a tutti

Allegati

Ultima modifica:

SatuRno17

Super member

Ciao Max, le reti neurali sicuramente possono tornare utili ma dobbiamo capire bene cosa mettere in input...e no non parlo dei numeri scritti sulle palline....questo perché la rete impara attraverso formule matematiche dunque inserendo i numeri estratti come input, la rete non farebbe nient' altro che i metodi sommativi. Io per input intendo i parametri fisici delle macchine (es. Tempi di mescolamento, velocità del flusso d'aria) ecco così si potrebbe veramente creare un modello concreto. Tuttavia questi parametri non li conosciamo quindi dobbiamo escogitare qualcosa di alternativo....

Ultima estrazione Lotto

-

Estrazione del lotto

giovedì 10 aprile 2025Bari5540191108Cagliari4084200736Firenze6012081074Genova8768516189Milano2049608204Napoli6289012129Palermo6369817870Roma1869264065Torino7483781681Venezia6481724302Nazionale0445305534Estrazione Simbolotto

Genova

2341353201

2341353201