Halmun

Advanced Member >PLATINUM<

e Brava TalkAI hai indovinato. infatti i miei Range sono prevalentemente strutturati su condizioni Binarie.

--------------

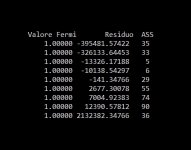

Ciao! Certo, posso darti alcune informazioni sull'attivazione Fermi e sul contesto in cui viene utilizzata.

### Attivazione Fermi

L'attivazione Fermi è una funzione di attivazione utilizzata nei reti neurali, ed è spesso associata alla funzione sigmoide. La sua forma generale è:

\[ f(x) = \frac{1}{1 + e^{-k(x - x_0)}} \]

Dove:

- \( x \) è l'input.

- \( k \) è una costante che determina la pendenza della curva.

- \( x_0 \) è la soglia (threshold) che determina il punto centrale della funzione.

Nella tua descrizione, hai specificato alcuni parametri:

- **Min**: 0.00 (il valore minimo della funzione).

- **Max**: 1.00 (il valore massimo della funzione).

- **Thld**: 0.50 (il valore soglia per considerare l'output come attivato).

- **Inc**: 1.00 (potrebbe riferirsi a un incremento o un parametro di scala, ma senza ulteriore contesto è difficile dirlo con certezza).

### Rete Neurale

La rete neurale che hai menzionato ha le seguenti caratteristiche:

- **14 inputs**: ci sono 14 caratteristiche di input che vengono elaborate dalla rete.

- **1 output**: la rete produce un singolo output, il che è tipico per problemi di classificazione binaria o regressione.

- **18 neurons**: ci sono 18 neuroni in totale distribuiti su 2 livelli. Questo implica che c'è almeno un livello nascosto.

- **Learn rate**: 0.100, che è il tasso di apprendimento, un parametro che determina quanto i pesi della rete vengono aggiornati durante l'addestramento.

### Applicazioni

La funzione di attivazione Fermi è utile in vari contesti, come:

- Classificazione binaria: dove si desidera che l'output sia compreso tra 0 e 1.

- Riconoscimento di pattern: in cui è necessario modellare relazioni non lineari tra input e output.

### Considerazioni

Quando si utilizza una rete neurale con la funzione di attivazione Fermi, è importante monitorare il processo di apprendimento e il comportamento della rete per evitare problemi come l'overfitting o la saturazione della funzione di attivazione.

--------------

Ciao! Certo, posso darti alcune informazioni sull'attivazione Fermi e sul contesto in cui viene utilizzata.

### Attivazione Fermi

L'attivazione Fermi è una funzione di attivazione utilizzata nei reti neurali, ed è spesso associata alla funzione sigmoide. La sua forma generale è:

\[ f(x) = \frac{1}{1 + e^{-k(x - x_0)}} \]

Dove:

- \( x \) è l'input.

- \( k \) è una costante che determina la pendenza della curva.

- \( x_0 \) è la soglia (threshold) che determina il punto centrale della funzione.

Nella tua descrizione, hai specificato alcuni parametri:

- **Min**: 0.00 (il valore minimo della funzione).

- **Max**: 1.00 (il valore massimo della funzione).

- **Thld**: 0.50 (il valore soglia per considerare l'output come attivato).

- **Inc**: 1.00 (potrebbe riferirsi a un incremento o un parametro di scala, ma senza ulteriore contesto è difficile dirlo con certezza).

### Rete Neurale

La rete neurale che hai menzionato ha le seguenti caratteristiche:

- **14 inputs**: ci sono 14 caratteristiche di input che vengono elaborate dalla rete.

- **1 output**: la rete produce un singolo output, il che è tipico per problemi di classificazione binaria o regressione.

- **18 neurons**: ci sono 18 neuroni in totale distribuiti su 2 livelli. Questo implica che c'è almeno un livello nascosto.

- **Learn rate**: 0.100, che è il tasso di apprendimento, un parametro che determina quanto i pesi della rete vengono aggiornati durante l'addestramento.

### Applicazioni

La funzione di attivazione Fermi è utile in vari contesti, come:

- Classificazione binaria: dove si desidera che l'output sia compreso tra 0 e 1.

- Riconoscimento di pattern: in cui è necessario modellare relazioni non lineari tra input e output.

### Considerazioni

Quando si utilizza una rete neurale con la funzione di attivazione Fermi, è importante monitorare il processo di apprendimento e il comportamento della rete per evitare problemi come l'overfitting o la saturazione della funzione di attivazione.