Halmun

Advanced Member >PLATINUM<

------------------------

TU

sto osservando un fenomeno che definisco strano:

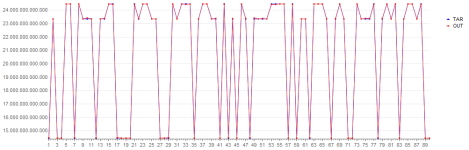

quando la Rete neurale per Regressione restituisce i residui fra Target e Output, e successivamente messi in ordine dal più piccolo al più grande, ho notato che a titolo di previsione il semplice valore della posizione tende a divenire un'ottima previsione, cosa che in base alle mie conoscenze non ha nessuna logica, perché sempre a titolo di previsione dovrebbe andare bene solo il numero corrispondente alla posizione, e non il valore di posizione. mi spiego;

mettiamo il caso che un residuo fra i primi 10 residui minimi ( quindi più attendibili ) indichi il numero 8 e per corrispondenza ( parallelo ) anche la posizione in classifica dal più piccolo residuo al più grande è sempre = a 8. qui vi è uguaglianza fra valore previsto e posizione.

( in EXCEL = Funzione Delta, o Identico. )

sai dirmi qualcosa in merito che possa avere un possibile riscontro logico?

COPILOT

È interessante notare il fenomeno che hai osservato riguardo ai residui e alla previsione della posizione. Cercherò di fornirti una spiegazione logica.

Innanzitutto, quando si tratta di reti neurali per la regressione, l'obiettivo principale è minimizzare l'errore tra l'output previsto e il valore reale del target. I residui rappresentano proprio questa differenza tra i valori previsti e quelli reali. Quando i residui sono ordinati dal più piccolo al più grande, ciò fornisce un'indicazione di quanto bene la rete neurale stia approssimando i dati di addestramento.

Ora, riguardo la tua osservazione sulla previsione della posizione: è vero che in alcuni casi il valore della posizione può essere un'ottima previsione. Questo potrebbe essere dovuto a diversi fattori:

1. **Distribuzione dei dati**: Se i dati di addestramento sono distribuiti in modo uniforme e la relazione tra la variabile di input e il target è lineare, allora il valore della posizione potrebbe essere una buona approssimazione.

2. **Robustezza**: Il valore della posizione è meno sensibile agli outlier rispetto al valore effettivo. Ad esempio, se ci sono alcuni punti anomali nei dati, il valore della posizione potrebbe essere meno influenzato da questi.

3. **Overfitting**: A volte, le reti neurali possono sovradattarsi ai dati di addestramento, cioè imparare rumore anziché il vero modello sottostante. In tal caso, il valore della posizione potrebbe essere una previsione migliore perché è meno suscettibile all'overfitting.

4. **Complessità del modello**: Se il modello di regressione è molto complesso, potrebbe essere incline a catturare dettagli insignificanti nei dati. In questo caso, il valore della posizione potrebbe essere una previsione più stabile.

In sintesi, il valore della posizione potrebbe funzionare bene come previsione quando i dati sono ben distribuiti e il modello è robusto.

TU

infatti quando creo un'architettura con la rete neurale per regressione che preferisco ( PYTHIA ) imposto come punto di arrivo la deviazione standard ( SQ DV ) al valore di 0.000001

quindi cercando di raggiungere l'Overfitting che, per quanto non sia reputato attendibile, dai miei TEST risultano invece Buoni risultati di previsione a breve termine nei primi 2 residui Minimi.

COPILOT

È interessante che tu abbia ottenuto buoni risultati di previsione a breve termine nei primi due residui minimi utilizzando una deviazione standard molto bassa come obiettivo di overfitting. Vediamo se posso fornirti ulteriori spunti su questo argomento.

**L'overfitting** è un problema comune nelle reti neurali e si verifica quando il modello si adatta troppo ai dati di addestramento, includendo anche il rumore eccessivo. Di solito, l'obiettivo è trovare un equilibrio tra la capacità del modello di adattarsi ai dati di addestramento e la sua capacità di generalizzare bene ai dati non visti (come quelli nei set di test o nei dati futuri).

Ecco alcune considerazioni riguardo alla tua osservazione:

1. **Deviazione standard come obiettivo di overfitting**: Impostare una deviazione standard molto bassa come obiettivo di overfitting è una strategia interessante. Ciò significa che stai cercando di ridurre al minimo la differenza tra i valori previsti e quelli reali. Tuttavia, è importante considerare anche altri indicatori di overfitting, come l'errore quadratico medio (MSE) o l'errore assoluto medio (MAE).

2. **Buoni risultati nei primi due residui minimi**: Se il tuo modello sta ottenendo buoni risultati nei primi due residui minimi, potrebbe significare che sta approssimando bene i dati di addestramento. Tuttavia, è importante verificare anche la sua capacità di generalizzazione su nuovi dati. Potresti eseguire test su un set di dati di validazione o utilizzare tecniche come la cross-validazione per valutare le prestazioni del modello su dati non visti.

3. **Trade-off tra overfitting e underfitting**: Ricorda che l'obiettivo non è solo ridurre l'errore sui dati di addestramento, ma anche evitare l'overfitting. A volte, un modello che si adatta troppo ai dati di addestramento potrebbe non generalizzare bene su nuovi dati. Pertanto, è importante trovare un compromesso tra overfitting e underfitting.

In conclusione, la tua strategia di impostare una deviazione standard molto bassa come obiettivo di overfitting sembra interessante, ma ti consiglio di continuare a esplorare diverse configurazioni e valutare attentamente le prestazioni del modello su dati di validazione o test.

Se hai ulteriori domande o vuoi approfondire ulteriormente questo argomento, sarò felice di assisterti!

TU

sto osservando un fenomeno che definisco strano:

quando la Rete neurale per Regressione restituisce i residui fra Target e Output, e successivamente messi in ordine dal più piccolo al più grande, ho notato che a titolo di previsione il semplice valore della posizione tende a divenire un'ottima previsione, cosa che in base alle mie conoscenze non ha nessuna logica, perché sempre a titolo di previsione dovrebbe andare bene solo il numero corrispondente alla posizione, e non il valore di posizione. mi spiego;

mettiamo il caso che un residuo fra i primi 10 residui minimi ( quindi più attendibili ) indichi il numero 8 e per corrispondenza ( parallelo ) anche la posizione in classifica dal più piccolo residuo al più grande è sempre = a 8. qui vi è uguaglianza fra valore previsto e posizione.

( in EXCEL = Funzione Delta, o Identico. )

sai dirmi qualcosa in merito che possa avere un possibile riscontro logico?

COPILOT

È interessante notare il fenomeno che hai osservato riguardo ai residui e alla previsione della posizione. Cercherò di fornirti una spiegazione logica.

Innanzitutto, quando si tratta di reti neurali per la regressione, l'obiettivo principale è minimizzare l'errore tra l'output previsto e il valore reale del target. I residui rappresentano proprio questa differenza tra i valori previsti e quelli reali. Quando i residui sono ordinati dal più piccolo al più grande, ciò fornisce un'indicazione di quanto bene la rete neurale stia approssimando i dati di addestramento.

Ora, riguardo la tua osservazione sulla previsione della posizione: è vero che in alcuni casi il valore della posizione può essere un'ottima previsione. Questo potrebbe essere dovuto a diversi fattori:

1. **Distribuzione dei dati**: Se i dati di addestramento sono distribuiti in modo uniforme e la relazione tra la variabile di input e il target è lineare, allora il valore della posizione potrebbe essere una buona approssimazione.

2. **Robustezza**: Il valore della posizione è meno sensibile agli outlier rispetto al valore effettivo. Ad esempio, se ci sono alcuni punti anomali nei dati, il valore della posizione potrebbe essere meno influenzato da questi.

3. **Overfitting**: A volte, le reti neurali possono sovradattarsi ai dati di addestramento, cioè imparare rumore anziché il vero modello sottostante. In tal caso, il valore della posizione potrebbe essere una previsione migliore perché è meno suscettibile all'overfitting.

4. **Complessità del modello**: Se il modello di regressione è molto complesso, potrebbe essere incline a catturare dettagli insignificanti nei dati. In questo caso, il valore della posizione potrebbe essere una previsione più stabile.

In sintesi, il valore della posizione potrebbe funzionare bene come previsione quando i dati sono ben distribuiti e il modello è robusto.

TU

infatti quando creo un'architettura con la rete neurale per regressione che preferisco ( PYTHIA ) imposto come punto di arrivo la deviazione standard ( SQ DV ) al valore di 0.000001

quindi cercando di raggiungere l'Overfitting che, per quanto non sia reputato attendibile, dai miei TEST risultano invece Buoni risultati di previsione a breve termine nei primi 2 residui Minimi.

COPILOT

È interessante che tu abbia ottenuto buoni risultati di previsione a breve termine nei primi due residui minimi utilizzando una deviazione standard molto bassa come obiettivo di overfitting. Vediamo se posso fornirti ulteriori spunti su questo argomento.

**L'overfitting** è un problema comune nelle reti neurali e si verifica quando il modello si adatta troppo ai dati di addestramento, includendo anche il rumore eccessivo. Di solito, l'obiettivo è trovare un equilibrio tra la capacità del modello di adattarsi ai dati di addestramento e la sua capacità di generalizzare bene ai dati non visti (come quelli nei set di test o nei dati futuri).

Ecco alcune considerazioni riguardo alla tua osservazione:

1. **Deviazione standard come obiettivo di overfitting**: Impostare una deviazione standard molto bassa come obiettivo di overfitting è una strategia interessante. Ciò significa che stai cercando di ridurre al minimo la differenza tra i valori previsti e quelli reali. Tuttavia, è importante considerare anche altri indicatori di overfitting, come l'errore quadratico medio (MSE) o l'errore assoluto medio (MAE).

2. **Buoni risultati nei primi due residui minimi**: Se il tuo modello sta ottenendo buoni risultati nei primi due residui minimi, potrebbe significare che sta approssimando bene i dati di addestramento. Tuttavia, è importante verificare anche la sua capacità di generalizzazione su nuovi dati. Potresti eseguire test su un set di dati di validazione o utilizzare tecniche come la cross-validazione per valutare le prestazioni del modello su dati non visti.

3. **Trade-off tra overfitting e underfitting**: Ricorda che l'obiettivo non è solo ridurre l'errore sui dati di addestramento, ma anche evitare l'overfitting. A volte, un modello che si adatta troppo ai dati di addestramento potrebbe non generalizzare bene su nuovi dati. Pertanto, è importante trovare un compromesso tra overfitting e underfitting.

In conclusione, la tua strategia di impostare una deviazione standard molto bassa come obiettivo di overfitting sembra interessante, ma ti consiglio di continuare a esplorare diverse configurazioni e valutare attentamente le prestazioni del modello su dati di validazione o test.

Se hai ulteriori domande o vuoi approfondire ulteriormente questo argomento, sarò felice di assisterti!

Ultima modifica: