FILE ALFA-3.PY

Io

puoi dirmi il significato di queste righe?

# Costruzione del modello model = Sequential() model.add(Embedding(len(tokenizer.word_index) + 1, 10, input_length=max_length)) model.add(LSTM(15)) model.add(Dense(len(tokenizer.word_index) + 1, activation='softmax')) model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

Copilot

Certo! Queste righe di codice sono utilizzate per costruire e compilare un modello di rete neurale sequenziale in Keras. Vediamo il significato di ciascuna parte:

model = Sequential(): Questa riga crea un modello di rete neurale sequenziale, che significa che gli strati del modello sono impilati uno dopo l'altro.

model.add(Embedding(len(tokenizer.word_index) + 1, 10, input_length=max_length)): Aggiunge uno strato di embedding, che mappa ogni parola (rappresentata da un indice intero) in un vettore di dimensione 10. len(tokenizer.word_index) + 1 è la dimensione del vocabolario, e input_length=max_length specifica la lunghezza degli input.

model.add(LSTM(15)): Aggiunge uno strato di LSTM (Long Short-Term Memory) con 15 unità, utile per catturare dipendenze a lungo termine nei dati sequenziali.

model.add(Dense(len(tokenizer.word_index) + 1, activation='softmax')): Aggiunge uno strato denso (completamente connesso) con len(tokenizer.word_index) + 1 unità di output e una funzione di attivazione softmax. Questo strato è solitamente usato per la classificazione.

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy']): Compila il modello, specificando l'algoritmo di ottimizzazione adam, la funzione di perdita categorical_crossentropy, e la metrica di valutazione accuracy.

In sintesi, questo codice definisce un modello di rete neurale per la classificazione di sequenze di parole, lo compila, e lo prepara per l'addestramento. Se hai altre domande o vuoi saperne di più su una parte specifica, fammi sapere!

Io

ho bisogno di comprendere bene questa parte: *model.add(Embedding(len(tokenizer.word_index) + 1, 10, input_length=max_length)): Aggiunge uno strato di embedding, che mappa ogni parola (rappresentata da un indice intero) in un vettore di dimensione 10. *

domande:

1° cosa è embedding?

2° la dimensione del vettore è impostata a 10, ma la lunghezza massima delle parole nel range da analizzare (Input) è 16, mentre la lunghezza minima è 3.

non sarebbe meglio impostare 16 come lunghezza del vettore?

Copilot

Un "embedding" è una tecnica di rappresentazione vettoriale di oggetti, nel caso del tuo modello, parole. In pratica, mappa ogni parola (o indice) in uno spazio vettoriale continuo di dimensione specificata. Questo permette al modello di apprendere relazioni e similarità tra parole. Piuttosto che trattare ogni parola come una entità distinta e indipendente, l'embedding consente di catturare informazioni semantiche.

Ora, rispondiamo alle tue domande:

Cosa è un embedding?

L'embedding è una rappresentazione densa e a bassa dimensione di variabili categoriche come parole. Nel contesto delle reti neurali, consente al modello di apprendere rappresentazioni utili delle parole in base al contesto in cui appaiono. È come tradurre parole in numeri che la rete può processare e comprendere meglio.

Dimensione del vettore di embedding: 10 vs 16?

La dimensione del vettore di embedding (10 nel tuo esempio) non deve necessariamente corrispondere alla lunghezza delle sequenze di input (max_length è 16 nel tuo esempio). La dimensione del vettore di embedding rappresenta la dimensionalità dello spazio vettoriale in cui le parole verranno mappate, mentre input_length rappresenta la lunghezza delle sequenze di input trattate dalla rete.

Puoi sperimentare con diverse dimensioni del vettore di embedding. Dimensioni più grandi potrebbero catturare più informazioni semantiche, ma aumentano anche la complessità del modello. Una dimensione 10 è comune come punto di partenza, ma puoi provare 16 o altre dimensioni per vedere se migliorano le prestazioni del tuo modello.

Ricorda, l'arte del machine learning spesso implica trovare il giusto equilibrio e ottimizzare parametri attraverso tentativi ed errori. Non esiste una risposta perfetta unica per tutte le situazioni.

Se hai altre domande o vuoi approfondire ulteriormente, sono qui per aiutarti!

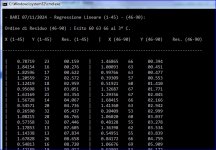

del resto i primi 3 negativi parlavano chiaro con la terzina 13 35 10 . per non parlare degli estremi iniziali, finali, e al punto 00.000 21-20-13-66 .... basta controllare nei 2 colpi successivi.