How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Nota: This feature may not be available in some browsers.

Stai usando un browser molto obsoleto. Puoi incorrere in problemi di visualizzazione di questo e altri siti oltre che in problemi di sicurezza. .

Dovresti aggiornarlo oppure usare usarne uno alternativo, moderno e sicuro.

Dovresti aggiornarlo oppure usare usarne uno alternativo, moderno e sicuro.

Buchi e....dintorni

- Creatore Discussione Elleuca

- Data di inizio

Rookie

Advanced Member >PLATINUM PLUS<

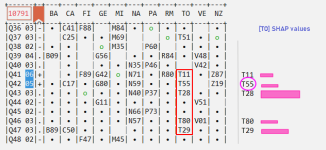

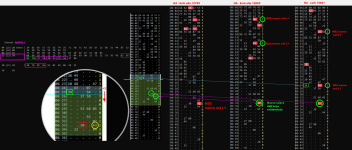

Alla situazione della Celeberrima Mole, di cui al post citato, si aggiunge quella della venus del Partenone, (nono)stante la miglior forbice resti ancora nella regione che diede i natali al Sommo Poeta. Restiamo a vedere se gli SHAP values esposti per le sfere L1s delle venus TORINO e NAPOLI sapranno esprimere opportunamente il valore della loro informata inferenza...

Vedi l'allegato 2311338

continua

Ritorniamo sugli SHAP values, visto che la sfera T29 e' sortita a colpo (cfr. post 5077 e 5078) per chiarire che cio' NON significa, ASSOLUTAMENTE, che le future ipotesi si riprodurranno allo stesso modo in ogni prossima occasione.

Con cio' premesso, I metodi SHAP, come noto agli addetti ai lavori, sono algoritmi che prendono misure sottostanti della sensibilita' delle caratteristiche e stimano una ragionevole decomposizione additiva da Statistiche di perturbazione NON additive; facendo attenzione alle situazioni che potrebbero includere la valutazione di modelli mai addestrati prima per le quali e' sempre consigliabile adottare set di input randomizzati sulle distribuzioni empiriche marginali.

In poche e semplici parole, ho sostituito il modello con "previsione attesa", con tutti i rivoli degli afferenti contributi. E se i contributi di una data caratteristica sono alti (valori assoluti) per molti campioni allora essa e' da ritenere importante. Come esposto, sinteticamente, nei casi in specie esposti sopra, le sfere T28, T29 per la venus TORINO (indicazioni in magenta) e N40, N71 per la venus NAPOLI (indicazioni in arancione). I valori SHAP sono un modo intelligente per calcolare i contributi delle varie statistiche quantitative raccolte e pesate. Tuttavia, se qualcuno (un laico non addentrato nella Scienza dei dati) obiettasse sul merito dell'affermazione che piu' e' alto il valore della variabile piu' e' probabile che questa variabile preveda una certa classe in qualche maniera avrebbe ragione, poiche' non e' questo il significato assoluto di cui si e' qui a discettare. Si tratta invece di ottenere (ogni volta) un'Inferenza Spiegabile, Informata, Consapevole e ...Riproducibile. In parole molto semplici, e' questo un modo (arbitrario ma non tanto...) per rendere comprensibili i modelli "Black Box" implementati.

p.s. Le formulazioni di importanza delle caratteristiche secondo la teoria dei giochi sono diventate popolari come modo per "spiegare" i modelli ML (Machine Learning). Questi metodi definiscono un gioco cooperativo tra le caratteristiche di un modello e distribuiscono l'influenza tra questi elementi di input utilizzando una qualche forma dei valori unici di Shapley del gioco. La giustificazione di questi metodi si basa su due pilastri: le loro proprietà matematiche desiderabili e la loro applicabilità a motivazioni specifiche per le spiegazioni.

Qui si sta tentando di mostrare che i problemi matematici sorgono quando i valori di Shapley vengono utilizzati per l'importanza delle caratteristiche, e che le soluzioni per mitigarli inducono necessariamente ulteriori complessità, come la necessità di ragionamento causale.

Attingendo allo scopo alle varie letterature disponibili sull'argomento per definire al meglio il valore di Shapley, si producono diversi modi sperimentali applicati al problema dell'importanza delle caratteristiche rilevate e desunte. E' di questo che si tratta...

Ultima modifica:

Rookie

Advanced Member >PLATINUM PLUS<

Alla situazione della Celeberrima Mole, di cui al post citato, si aggiunge quella della venus del Partenone, (nono)stante la miglior forbice resti ancora nella regione che diede i natali al Sommo Poeta. Restiamo a vedere se gli SHAP values esposti per le sfere L1s delle venus TORINO e NAPOLI sapranno esprimere opportunamente il valore della loro informata inferenza...

Vedi l'allegato 2311338

aggiornamento

Ultima modifica:

Ciccio90

Advanced Member >PLATINUM<

grazie maestro

Rookie

Advanced Member >PLATINUM PLUS<

TORINO, al secondo colpo, rilascia un altro set L1, sfera T55, presente tra i due SHAP values esposti come seconde linee nella scala...di cui al post 5082, in questa stessa pagina.Ritorniamo sugli SHAP values, visto che la sfera T29 e' sortita a colpo (cfr. post 5077 e 5078) per chiarire che cio' NON significa, ASSOLUTAMENTE, che le future ipotesi si riprodurranno allo stesso modo in ogni prossima occasione.

Con cio' premesso, I metodi SHAP, come noto agli addetti ai lavori, sono algoritmi che prendono misure sottostanti della sensibilita' delle caratteristiche e stimano una ragionevole decomposizione additiva da Statistiche di perturbazione NON additive; facendo attenzione alle situazioni che potrebbero includere la valutazione di modelli mai addestrati prima per le quali e' sempre consigliabile adottare set di input randomizzati sulle distribuzioni empiriche marginali.

In poche e semplici parole, ho sostituito il modello con "previsione attesa", con tutti i rivoli degli afferenti contributi. E se i contributi di una data caratteristica sono alti (valori assoluti) per molti campioni allora essa e' da ritenere importante. Come esposto, sinteticamente, nei casi in specie esposti sopra, le sfere T28, T29 per la venus TORINO (indicazioni in magenta) e N40, N71 per la venus NAPOLI (indicazioni in arancione). I valori SHAP sono un modo intelligente per calcolare i contributi delle varie statistiche quantitative raccolte e pesate. Tuttavia, se qualcuno (un laico non addentrato nella Scienza dei dati) obiettasse sul merito dell'affermazione che piu' e' alto il valore della variabile piu' e' probabile che questa variabile preveda una certa classe in qualche maniera avrebbe ragione, poiche' non e' questo il significato assoluto di cui si e' qui a discettare. Si tratta invece di ottenere (ogni volta) un'Inferenza Spiegabile, Informata, Consapevole e ...Riproducibile. In parole molto semplici, e' questo un modo (arbitrario ma non tanto...) per rendere comprensibili i modelli "Black Box" implementati.

Vedi l'allegato 2311376

p.s. Le formulazioni di importanza delle caratteristiche secondo la teoria dei giochi sono diventate popolari come modo per "spiegare" i modelli ML (Machine Learning). Questi metodi definiscono un gioco cooperativo tra le caratteristiche di un modello e distribuiscono l'influenza tra questi elementi di input utilizzando una qualche forma dei valori unici di Shapley del gioco. La giustificazione di questi metodi si basa su due pilastri: le loro proprietà matematiche desiderabili e la loro applicabilità a motivazioni specifiche per le spiegazioni.

Qui si sta tentando di mostrare che i problemi matematici sorgono quando i valori di Shapley vengono utilizzati per l'importanza delle caratteristiche, e che le soluzioni per mitigarli inducono necessariamente ulteriori complessità, come la necessità di ragionamento causale.

Attingendo allo scopo alle varie letterature disponibili sull'argomento per definire al meglio il valore di Shapley, si producono diversi modi sperimentali applicati al problema dell'importanza delle caratteristiche rilevate e desunte. E' di questo che si tratta...

I dati della DCS aggiornati dopo la 10793 (23 gennaio)

E come d'abitudine, restiamo a guardare... quale SHAP value verra' fuori dalla scatola nera afferente alla venus ai piedi del Vesuvio...

Ultima modifica:

Rookie

Advanced Member >PLATINUM PLUS<

Buongiorno papaia, se ti interessa approfondire l'argomento qui c'e' un link del lavoro di Scott Lundberg:ciao rookie Elleuca e se posso chiedere vorrei sapere quale libreria usate per ottenere i valori shap'?

saluti

https://shap.readthedocs.io/en/latest/index.html dalla quale dovresti pervenire a tutte le risposte alle tue domande...

Frattanto, buona domenica

Rookie

Advanced Member >PLATINUM PLUS<

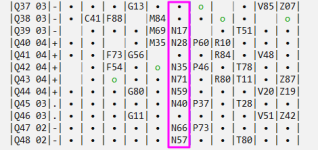

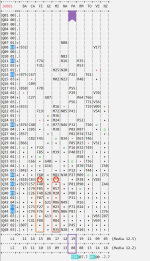

NAPOLI, sfera N71... un altro SHAP Value (significativo) andato a segno..

Sebbene, la tenutaria della miglior forbice sia la venus in riva all'Arno, per le prossime estrazioni saranno esposti gli SHAP values di alcune sfere L1s afferenti alla venus Meneghina

continua... nel prossimo post.

Vedi l'allegato 2311670

... Come esposto, sinteticamente, nei casi in specie esposti sopra, le sfere T28, T29 per la venus TORINO (indicazioni in magenta) e N40, N71 per la venus NAPOLI (indicazioni in arancione). I valori SHAP sono un modo intelligente per calcolare i contributi delle varie statistiche quantitative raccolte e pesate...

MILANO, M74 e ambetto (sortito M79)Mentre sono in arrivo i nuovi PB che pertengono alle Venus, GENOVA & MILANO, il monitoraggio delle Dicotomia tra Chiari & Scuri (DCS) continua ad essere ancora appannaggio della venus afferente alla citta' in riva all'Arno

Per le due venus di cui e' atteso un nuovo PB, le sfere papabili al momento sono pariteticamente distribuite, ovvero sono tre per ambedue venus:

MI: {M78,M88,M39} con M74

Sebbene, la tenutaria della miglior forbice sia la venus in riva all'Arno, per le prossime estrazioni saranno esposti gli SHAP values di alcune sfere L1s afferenti alla venus Meneghina

continua... nel prossimo post.

Vedi l'allegato 2311670

Ultima modifica:

Rookie

Advanced Member >PLATINUM PLUS<

NAPOLI, sfera N71... un altro SHAP Value (significativo) andato a segno..

MILANO, M74 e ambetto (sortito M79)

Sebbene, la tenutaria della miglior forbice sia la venus in riva all'Arno, per le prossime estrazioni saranno esposti gli SHAP values di alcune sfere L1s afferenti alla venus Meneghina

continua...

Vedi l'allegato 2311670

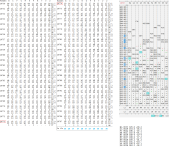

Monitoraggio puntuale e sinottico della DCS afferente alle 11 venus, nelle ultime 48 estrazioni, aggiornato alla 10798 (del 31 gennaio):

Ultima modifica:

Rookie

Advanced Member >PLATINUM PLUS<

La venus NAPOLI, nello scenario primo LZero (sua Altezza, il PB), dovrebbe oggettivare a breve il suo tipico effetto, come si puo' facilmente evincere dalle informazioni sotto riportate. Segnaliamo la Sontuosa e Sovrabbondante popolazione di sfere afferenti ai sets L2...

Al momento i sets L1 in corsa per il PB sono solo 4, se Crono, Signore del Tempo (libero ), lo consentira' proveremo a ridurre al minimo questa quantita' di concorrenti per il prossimo imminente PB, sotto al Vesuvio, la cui oggettivazione potrebbe accompagnarsi (generosamente) con sfere rilasciate dai sets L2

), lo consentira' proveremo a ridurre al minimo questa quantita' di concorrenti per il prossimo imminente PB, sotto al Vesuvio, la cui oggettivazione potrebbe accompagnarsi (generosamente) con sfere rilasciate dai sets L2

continua...

Al momento i sets L1 in corsa per il PB sono solo 4, se Crono, Signore del Tempo (libero

continua...

Ultima modifica:

Rookie

Advanced Member >PLATINUM PLUS<

La venus NAPOLI, nello scenario primo LZero (sua Altezza, il PB), dovrebbe oggettivare a breve il suo tipico effetto, come si puo' facilmente evincere dalle informazioni sotto riportate. Segnaliamo la Sontuosa e Sovrabbondante popolazione di sfere afferenti ai sets L2...

Al momento i sets L1 in corsa per il PB sono solo 4, se Crono, Signore del Tempo (libero), lo consentira' proveremo a ridurre al minimo questa quantita' di concorrenti per il prossimo imminente PB, sotto al Vesuvio, la cui oggettivazione potrebbe accompagnarsi (generosamente) con sfere rilasciate dai sets L2

continua...

Vedi l'allegato 2311745

aggiornamento: La zona piu' interessante per capire quali L2 potranno contribuire alla causa e' delimitata nell'area da cui e' aspettabile che scaturiscano variazioni che pertengono alla struttura del turt in essa giacente.

Quest'area e', in primis in sofferenza di sets L1, e poiche' i naturali fornitori di L1 sono i sets L2, deinde per la selezione dei migliori sets L2, bisogna guardare all'area deficitaria di sets L1. Ergo, ne rileviamo (al momento) 3 nell'area piu'estesa (37 58, 30 43 e 22 64), con concreta possibilita' di incremento (cfr. 63 07 e 34 54).

Per quanto pertiene alla corsa al PB, ossia al piu' basso tra gli LZero, enumerati dal migliore a scendere in dipendenza dai loro SHAP values : N46, N05, N20, N78

Come sempre restiamo a guardare...

Ultima modifica:

Rookie

Advanced Member >PLATINUM PLUS<

aggiornamento: La zona piu' interessante per capire quali L2 potranno contribuire alla causa e' delimitata nell'area da cui e' aspettabile che scaturiscano variazioni che pertengono alla struttura del turt in essa giacente.

Quest'area e', in primis in sofferenza di sets L1, e poiche' i naturali fornitori di L1 sono i sets L2, deinde per la selezione dei migliori sets L2, bisogna guardare all'area deficitaria di sets L1. Ergo, ne rileviamo (al momento) 3 nell'area piu'estesa (37 58, 30 43 e 22 64), con concreta possibilita' di incremento (cfr. 63 07 e 34 54).

Per quanto pertiene alla corsa al PB, ossia al piu' basso tra gli LZero, enumerati dal migliore a scendere in dipendenza dai loro SHAP values : N46, N05, N20, N78

Come sempre restiamo a guardare...

Vedi l'allegato 2311782

Come atteso, la venus NAPOLI ha rilasciato un L1 oggettivato da uno dei 3 sets L2, giacente nell'area del turt selezionata, di cui al precedente post

Rookie

Advanced Member >PLATINUM PLUS<

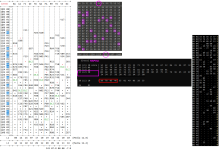

Come atteso, la venus NAPOLI ha rilasciato un L1 oggettivato da uno dei 3 sets L2, giacente nell'area del turt selezionata, di cui al precedente post

Vedi l'allegato 2311796

NAPOLI: Il primo dei due sets L1 attesi proveniente dagli hangar dei sets L2, e' atterrato nell'area evidenziata e dunque restiamo ad osservare quale sara' il secondo L2 a oggettivare il secondo set L1

Frattanto qui e' la nuova situazione delle forbici tra Chiari & Scuri aggiornata alla 10799; nelle cui pieghe vi sono aspetti interessanti che vale la pena monitorare!

E come d'abitudine, restiamo ad osservare per imparare dal Caso... delle venus!

Ultima modifica:

Rookie

Advanced Member >PLATINUM PLUS<

aggiornamento: La zona piu' interessante per capire quali L2 potranno contribuire alla causa e' delimitata nell'area da cui e' aspettabile che scaturiscano variazioni che pertengono alla struttura del turt in essa giacente.

Quest'area e', in primis in sofferenza di sets L1, e poiche' i naturali fornitori di L1 sono i sets L2, deinde per la selezione dei migliori sets L2, bisogna guardare all'area deficitaria di sets L1. Ergo, ne rileviamo (al momento) 3 nell'area piu'estesa (37 58, 30 43 e 22 64), con concreta possibilita' di incremento (cfr. 63 07 e 34 54).

Come atteso, la venus NAPOLI ha rilasciato un L1 oggettivato da uno dei 3 sets L2, giacente nell'area del turt selezionata, di cui al precedente post

Vedi l'allegato 2311796

Dall'area evidenziata, dopo due sole estrazioni, viene rilasciato uno dei due L1 (N55 e N02) che hanno avuto un rendez-vous con due sfere rilasciate dai sets L2, che han lasciato in solitudine due nuovi L1, che vanno a ripopolare la schiera dei loro pari

Ultima modifica:

Buonasera a tutti. La F 27 non era da giocare ma da monitorare, Ed è stata la scelta più corretta per due motivi.Buonasera Rookie e a tutti coloro che ci leggono. Segnalo solo la

F27

NON E ‘ DA GIOCARE MA DA STUDIARE.Sia che essa esca oppure no in tempi brevi, ci darà delle indicazioni per il futuro

Uno perché non è uscita

Due perché dagli errori si impara molto e dalla F27 ho imparato molte cose .

Paradossalmente se lo riuscissi a fare per 85 sfere e per ogni estrazione avrei fatto bingo!!!!

A presto

Rookie

Advanced Member >PLATINUM PLUS<

Dall'area evidenziata, dopo due sole estrazioni, viene rilasciato uno dei due L1 (N55 e N02) che hanno avuto un rendez-vous con due sfere rilasciate dai sets L2, che han lasciato in solitudine due nuovi L1, che vanno a ripopolare la schiera dei loro pari.

Vedi l'allegato 2311875

NAPOLI - Stasera al terzo colpo, viene rilasciata anche la sfera afferente al secondo set L1, N55, il quale giaceva nell'area evidenziata. E anche questa sfera s'accompagna a due sfere afferenti ai sets L2

Altro splendido e fausto esempio, di LOTTO Quantitativo

E come anticipato, nel post citato qui sotto, vi erano aspetti interessanti che valeva la pena monitorare, e si e' rivelato proprio come (pre)detto... Abbiamo imparato nuove cose... da guardare e (tra)guardare

Frattanto qui e' la nuova situazione delle forbici tra Chiari & Scuri aggiornata alla 10799; nelle cui pieghe vi sono aspetti interessanti che vale la pena monitorare!

E come d'abitudine, restiamo ad osservare per imparare dal Caso... delle venus!

Ultima modifica:

Ciccio90

Advanced Member >PLATINUM<

grazie maestroNAPOLI - Stasera al terzo colpo, viene rilasciata anche la sfera afferente al secondo set L1, N55, il quale giaceva nell'area evidenziata. E anche questo si accompagna a due sfere afferenti ai sets L2

Altro splendido e fausto esempio, di LOTTO Quantitativo

Vedi l'allegato 2311910

E come anticipato, nel post citato qui sotto, vi erano aspetti interessanti che valeva la pena monitorare, Ed e' stato proprio come (pre)detto! Abbiamo imparato nuove cose... da guarda e (tra)guardare

Rookie

Advanced Member >PLATINUM PLUS<

NAPOLI - Stasera al terzo colpo, viene rilasciata anche la sfera afferente al secondo set L1, N55, il quale giaceva nell'area evidenziata. E anche questa sfera s'accompagna a due sfere afferenti ai sets L2sovrappopolati!

Altro splendido e fausto esempio, di LOTTO Quantitativo

Vedi l'allegato 2311910

E come anticipato, nel post citato qui sotto, vi erano aspetti interessanti che valeva la pena monitorare, e si e' rivelato proprio come (pre)detto... Abbiamo imparato nuove cose... da guardare e (tra)guardare

A questo post (qui sopra) mancava la parte piu' importante, ossia l'oggettivazione del primo LZero ai piedi del Vesuvio

dal post # 5091

La venus NAPOLI, nello scenario primo LZero (sua Altezza, il PB), dovrebbe oggettivare a breve il suo tipico effetto, come si puo' facilmente evincere dalle informazioni sotto riportate. Segnaliamo la Sontuosa e Sovrabbondante popolazione di sfere afferenti ai sets L2...

Al momento i sets L1 in corsa per il PB sono solo 4, se Crono, Signore del Tempo (libero), lo consentira' proveremo a ridurre al minimo questa quantita' di concorrenti per il prossimo imminente PB, sotto al Vesuvio, la cui oggettivazione potrebbe accompagnarsi (generosamente) con sfere rilasciate dai sets L2

Infine, qui sotto, e' riportata la nuova situazione della nostra DICOTOMIA tra Chiari & Scuri, dalla quale si evince che (al momento) e' la venus della Conca d'oro la tenutaria della miglior forbice. A questo, vi e' anche da aggiungere che nelle due aree in evidenza, pertinenti alle venus FIRENZE e MILANO, sono delimitate due aree suscettibili di apportare veloci variazioni quantitative

E come sempre restiamo ad osservare, per imparare dal Caso generato dalle venus

Ultima modifica:

Ultima estrazione Lotto

-

Estrazione del lotto

martedì 03 marzo 2026Bari3668145150Cagliari2360824936Firenze3248258288Genova0573607167Milano4104603736Napoli4268634449Palermo3788081752Roma4966896074Torino0524228973Venezia4706611864Nazionale6639677418Estrazione Simbolotto

Firenze

0533302734

0533302734