How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Nota: This feature may not be available in some browsers.

Stai usando un browser molto obsoleto. Puoi incorrere in problemi di visualizzazione di questo e altri siti oltre che in problemi di sicurezza. .

Dovresti aggiornarlo oppure usare usarne uno alternativo, moderno e sicuro.

Dovresti aggiornarlo oppure usare usarne uno alternativo, moderno e sicuro.

Rete Neurale

- Creatore Discussione mirapep

- Data di inizio

lotto_tom75

Advanced Premium Member

Altre info relativi ai parametri di NNLP by my friend...

1. Learning Rate: Il learning rate determina la velocità con cui il modello apprende dai dati di addestramento. Valori più alti di learning rate possono accelerare il processo di addestramento, ma potrebbero compromettere la precisione. Inizia con un valore di learning rate medio, ad esempio 0.01, e successivamente puoi sperimentare con valori più alti o più bassi per ottenere risultati ottimali.

2. Momentum: Il momentum è un parametro che accelera la velocità di apprendimento del modello in direzione dei gradienti steepesti. Puoi impostare il valore di momentum su 0.0 se non desideri applicarlo nell'addestramento iniziale. In caso contrario, puoi iniziare con un valore basso, ad esempio 0.5, e successivamente regolarlo in base ai risultati che ottieni.

3. Noise: Il parametro di rumore (noise) viene utilizzato per introdurre un certo grado di casualità nell'addestramento del modello. Puoi impostare il valore di noise su 0.0 se non desideri applicarlo. Altrimenti, puoi sperimentare con valori bassi, ad esempio 0.01, per vedere se migliora la capacità di generalizzazione del modello.

4. Threshold (stop training): Il parametro di threshold determina il valore di errore medio che il modello deve raggiungere per fermare l'addestramento. Puoi impostare un valore di threshold ragionevole, ad esempio 0.001, in modo che l'addestramento si interrompa quando il modello raggiunge una buona precisione.

5. Hidden Layer Neurons: Il numero di neuroni nel livello nascosto influisce sulla complessità del modello e sulla sua capacità di apprendimento. Inizia con un numero moderato di neuroni, ad esempio 10, e successivamente puoi sperimentare con valori più alti o più bassi per trovare il giusto equilibrio tra complessità e prestazioni.

6. Training Data Range: Questo parametro determina il numero di estrazioni di addestramento da utilizzare. Puoi impostare un valore pari al numero di estrazioni disponibili, in questo caso 18, per utilizzare tutte le estrazioni come dati di addestramento.

7. Skip Training Data (latest): Puoi utilizzare questo parametro per escludere un certo numero di estrazioni più recenti dall'addestramento. Puoi impostarlo su 0 per includere tutte le estrazioni nell'addestramento.

8. Process Priority: Questo parametro regola la priorità di esecuzione del programma. Puoi lasciare il valore predefinito o impostarlo in base alle tue preferenze o alla capacità del tuo sistema.

9. Fixed Seed Input Weights: Se desideri riproducibilità nei risultati, puoi impostare un valore specifico per i pesi iniziali dei neuroni. In caso contrario, puoi lasciare questo parametro disabilitato.

Total Error: Questa voce indica l'errore totale ottenuto dal processo di addestramento della rete neurale. L'errore rappresenta la differenza tra i numeri previsti dalla rete neurale e i numeri effettivi estratti nella storia delle estrazioni.

Average Error: Questa voce rappresenta l'errore medio ottenuto dal processo di addestramento. È calcolato dividendo il valore del Total Error per il numero totale di estrazioni utilizzate per l'addestramento.

Last Error: Indica l'errore ottenuto nell'ultima fase di addestramento della rete neurale. Rappresenta la differenza tra i numeri previsti dalla rete e i numeri effettivamente estratti nella fase di addestramento finale.

Date Time: Questa voce indica la data e l'ora in cui è stato effettuato l'addestramento della rete neurale o il momento in cui sono stati generati i picks (scelte) della rete neurale.

NN Settings: Questa voce riporta le impostazioni attuali della rete neurale, che comprendono i parametri di configurazione che hai selezionato come learning rate, momentum, noise, hidden layer neurons, ecc.

Hits with skipped training: Questa voce mostra il numero di corrispondenze (hits) tra i numeri estratti nella storia delle estrazioni e i numeri previsti dalla rete neurale, considerando anche le estrazioni che sono state saltate durante l'addestramento.

Ricorda che queste sono solo linee guida generali e potrebbe essere necessario adattare i parametri in base al tuo specifico caso di studio. Sperimenta con diversi valori e osserva come influiscono sui risultati. Inoltre, assicurati di avere una quantità significativa di dati di addestramento per ottenere risultati più accurati.

Per quanto riguarda i miei test iniziali per adesso mi pare che il limite supportato di righe (estrazioni) per NNLP sia di 5400 ca. Risulta anche a voi? Altrimenti quante righe siete riusciti a caricare al massimo all'interno del programma?

1. Learning Rate: Il learning rate determina la velocità con cui il modello apprende dai dati di addestramento. Valori più alti di learning rate possono accelerare il processo di addestramento, ma potrebbero compromettere la precisione. Inizia con un valore di learning rate medio, ad esempio 0.01, e successivamente puoi sperimentare con valori più alti o più bassi per ottenere risultati ottimali.

2. Momentum: Il momentum è un parametro che accelera la velocità di apprendimento del modello in direzione dei gradienti steepesti. Puoi impostare il valore di momentum su 0.0 se non desideri applicarlo nell'addestramento iniziale. In caso contrario, puoi iniziare con un valore basso, ad esempio 0.5, e successivamente regolarlo in base ai risultati che ottieni.

3. Noise: Il parametro di rumore (noise) viene utilizzato per introdurre un certo grado di casualità nell'addestramento del modello. Puoi impostare il valore di noise su 0.0 se non desideri applicarlo. Altrimenti, puoi sperimentare con valori bassi, ad esempio 0.01, per vedere se migliora la capacità di generalizzazione del modello.

4. Threshold (stop training): Il parametro di threshold determina il valore di errore medio che il modello deve raggiungere per fermare l'addestramento. Puoi impostare un valore di threshold ragionevole, ad esempio 0.001, in modo che l'addestramento si interrompa quando il modello raggiunge una buona precisione.

5. Hidden Layer Neurons: Il numero di neuroni nel livello nascosto influisce sulla complessità del modello e sulla sua capacità di apprendimento. Inizia con un numero moderato di neuroni, ad esempio 10, e successivamente puoi sperimentare con valori più alti o più bassi per trovare il giusto equilibrio tra complessità e prestazioni.

6. Training Data Range: Questo parametro determina il numero di estrazioni di addestramento da utilizzare. Puoi impostare un valore pari al numero di estrazioni disponibili, in questo caso 18, per utilizzare tutte le estrazioni come dati di addestramento.

7. Skip Training Data (latest): Puoi utilizzare questo parametro per escludere un certo numero di estrazioni più recenti dall'addestramento. Puoi impostarlo su 0 per includere tutte le estrazioni nell'addestramento.

8. Process Priority: Questo parametro regola la priorità di esecuzione del programma. Puoi lasciare il valore predefinito o impostarlo in base alle tue preferenze o alla capacità del tuo sistema.

9. Fixed Seed Input Weights: Se desideri riproducibilità nei risultati, puoi impostare un valore specifico per i pesi iniziali dei neuroni. In caso contrario, puoi lasciare questo parametro disabilitato.

Total Error: Questa voce indica l'errore totale ottenuto dal processo di addestramento della rete neurale. L'errore rappresenta la differenza tra i numeri previsti dalla rete neurale e i numeri effettivi estratti nella storia delle estrazioni.

Average Error: Questa voce rappresenta l'errore medio ottenuto dal processo di addestramento. È calcolato dividendo il valore del Total Error per il numero totale di estrazioni utilizzate per l'addestramento.

Last Error: Indica l'errore ottenuto nell'ultima fase di addestramento della rete neurale. Rappresenta la differenza tra i numeri previsti dalla rete e i numeri effettivamente estratti nella fase di addestramento finale.

Date Time: Questa voce indica la data e l'ora in cui è stato effettuato l'addestramento della rete neurale o il momento in cui sono stati generati i picks (scelte) della rete neurale.

NN Settings: Questa voce riporta le impostazioni attuali della rete neurale, che comprendono i parametri di configurazione che hai selezionato come learning rate, momentum, noise, hidden layer neurons, ecc.

Hits with skipped training: Questa voce mostra il numero di corrispondenze (hits) tra i numeri estratti nella storia delle estrazioni e i numeri previsti dalla rete neurale, considerando anche le estrazioni che sono state saltate durante l'addestramento.

Ricorda che queste sono solo linee guida generali e potrebbe essere necessario adattare i parametri in base al tuo specifico caso di studio. Sperimenta con diversi valori e osserva come influiscono sui risultati. Inoltre, assicurati di avere una quantità significativa di dati di addestramento per ottenere risultati più accurati.

Per quanto riguarda i miei test iniziali per adesso mi pare che il limite supportato di righe (estrazioni) per NNLP sia di 5400 ca. Risulta anche a voi? Altrimenti quante righe siete riusciti a caricare al massimo all'interno del programma?

lotto_tom75

Advanced Premium Member

Due domande.

partendo dai 5 estratti, posso estrapolare solo pick da 2 numeri? ... a me pare di no

quando imposto diversi pick ... che faccio prendo il più presente?

Non credo che con quel programma NNPL si possa scegliere la dimensione del pick di uscita rispetto ai alla classe dei dati di estrazioni importate...

- Puoi prendere in considerazione diversi approcci, a seconda delle tue preferenze e dell'obiettivo dell'analisi. Alcune opzioni comuni potrebbero includere:

- Pick più frequente: Se hai estratto più pick, puoi scegliere la pick che appare più frequentemente tra le estrazioni passate. Questo può essere utile se stai cercando di identificare i numeri più comuni o di maggior interesse.

- Pick con la più bassa media di errore: Se stai utilizzando un modello di rete neurale o un algoritmo che produce valori di errore per ogni pick, puoi scegliere la pick con la media di errore più bassa. Questo potrebbe indicare una maggiore precisione o adattamento del modello alle estrazioni passate.

- Pick basata su altri criteri: A seconda del contesto o degli obiettivi specifici, potresti prendere in considerazione altri fattori come la varietà dei numeri nella pick, la presenza di sequenze o altre caratteristiche desiderate.

lotto_tom75

Advanced Premium Member

9. Fixed Seed Input Weights: ABILITATO "Se desideri riproducibilità nei risultati, puoi impostare un valore specifico per i pesi iniziali dei neuroni."

Ho mantenuto inalterati parameri e Draw ma non mi restituisce gli stessi picks... dove sbaglio.

Vedi l'allegato 2259973

Se hai abilitato l'opzione "Fixed Seed Input Weights" e hai mantenuto tutti gli altri parametri e i dati di input identici, dovresti ottenere gli stessi picks ogni volta che esegui il programma. Tuttavia, ci sono alcune possibili ragioni per cui potresti ottenere risultati diversi:

- Verifica che il valore del "Fixed Seed Input Weights" sia lo stesso in tutte le tue esecuzioni. Se cambi il valore del seed, anche di un piccolo valore, potresti ottenere picks diversi.

- Assicurati di avere la stessa versione del programma in tutte le tue esecuzioni. Se stai utilizzando diverse versioni o build del programma, potrebbero esserci differenze nei risultati.

- Controlla se ci sono altre variabili o parametri che potrebbero influire sui picks generati. Ad esempio, se ci sono parametri casuali o fluttuanti nel processo di generazione dei picks, potrebbero influenzare i risultati anche con lo stesso seed.

- Verifica se ci sono errori durante il caricamento dei dati di input o durante il processo di addestramento della rete neurale. Se ci sono problemi nel caricamento dei dati o nel processo di addestramento, potrebbe influire sui risultati.

lotto_tom75

Advanced Premium Member

Buongiorno,

tom che programma stai utilizzando?

Quello che hai condiviso tu mirapep : NNLP

lotto_tom75

Advanced Premium Member

Tom questa rete Neural Network Lottery Picker 2.1 non salva i settaggi, io la trovo poco funzionale.

A mio parere con NNLP si perde solo tempo.

Se proprio vogliamo approfondire l'argomento bisogna cercare qualcosa di funzionale.

Ciao

I settaggi claudio li trovi salvati nel file txt di report alla voce:

NN Settings: Questa voce riporta le impostazioni attuali della rete neurale, che comprendono i parametri di configurazione che hai selezionato come learning rate, momentum, noise, hidden layer neurons, ecc.

Il problema credo comunque che non sia tanto il programma in oggetto che tra tutti stiamo provando a testare con scarsi risultati bensì nel non saperlo sfruttare adeguatamente per le poche o nulle conoscenze che tra tutti abbiamo riguardo questa potenziale e affascinante materia... delle "reti neurali applicate al calcolo predittivo"

lotto_tom75

Advanced Premium Member

Proposta elaborazionale collettiva: partendo da un numero di ultime estrazioni (es. 5400) e ruota (es. MILANO o per il prossimo mese NAPOLI) comuni (x massima omogeneità di output) proviamo a vedere tra tutti di raggiungere il minimo valore possibile di total error (in grassetto nero) e average error (in grassetto rosso)? Good Saturday

es.

2306,99987626269;0,653561855323631;0,389561753023133;tempo:3 minuti;Learning Rate:0,014935| Momentum: 0,526657| Noise:0,527|Threshold Error:0|Hidden Neurons:50|Test Data Range:5401

Ps: ovviamente ognuno dovrà mettere anche la propria configurazione di NN Settings (in grassetto blu) e il tempo indicativo della propria ricerca (in grassetto verde). I numeri relativi invece non li metterei per non creare confusione e false aspettative durante questi test di tipo neurale puramente teorici.

es.

2306,99987626269;0,653561855323631;0,389561753023133;tempo:3 minuti;Learning Rate:0,014935| Momentum: 0,526657| Noise:0,527|Threshold Error:0|Hidden Neurons:50|Test Data Range:5401

Ps: ovviamente ognuno dovrà mettere anche la propria configurazione di NN Settings (in grassetto blu) e il tempo indicativo della propria ricerca (in grassetto verde). I numeri relativi invece non li metterei per non creare confusione e false aspettative durante questi test di tipo neurale puramente teorici.

Ultima modifica:

Halmun

Advanced Member >PLATINUM<

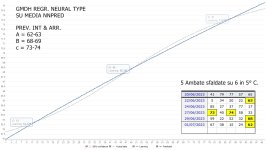

non conosco la rete che state utilizzando, io ne uso altre, prevalentemente per regressione, e sinceramente dopo vari anni di utilizzo non posso lamentarmi. ad una rete neurale non interessano ritardi, frequenze, scompensi ecc. ecc. a meno che non si analizzino RANGE preparati per casi in questione. io mi sono creato fogli excel di conversione-dati dei risultati delle reti che utilizzo, e successivamente tramite filtri-excel e quant'altro traggo le mie personali deduzioni.

ma come ogni strategia anche i risultati di una rete vanno seguiti passo-passo, e solo attraverso l'osservazione dei periodi-momenti positivi si deve decidere se attaccare il gioco o meno, e lungi dal far polemiche sterili, ma chi dice che non servono a nulla o che non aiutino a raggiungere determinati risultati si sbaglia di grosso, o perlomeno non sa di cosa parla.

le reti analizzano numeri, che siano valori mensili o annuali dei guadagni di una attività, o andamenti statistici di previsione per le vendite, o l'andamento statistico o meno di determinati gruppi numerici al LOTTO non vi è alcuna differenza.

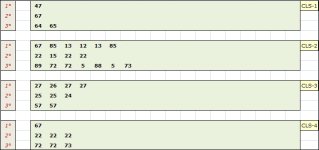

di seguito l'ultimo recente esempio ( ne ho a decine, e alcuni con esiti anche superiori ) tratto da una scansione con una mia Rete, dove i primi classificati per regressione dimostrano come al solito, e ormai da anni una certa attendibilità.

in questo caso le seconde posizioni. vedi foto.

BARI - Fine Data Range Analizzato 29/06/2023

osserviamo nella foto i 2°i classificati :

67-22-15-25-24

Esito 15 24 67 al 1° C.

ma come ogni strategia anche i risultati di una rete vanno seguiti passo-passo, e solo attraverso l'osservazione dei periodi-momenti positivi si deve decidere se attaccare il gioco o meno, e lungi dal far polemiche sterili, ma chi dice che non servono a nulla o che non aiutino a raggiungere determinati risultati si sbaglia di grosso, o perlomeno non sa di cosa parla.

le reti analizzano numeri, che siano valori mensili o annuali dei guadagni di una attività, o andamenti statistici di previsione per le vendite, o l'andamento statistico o meno di determinati gruppi numerici al LOTTO non vi è alcuna differenza.

di seguito l'ultimo recente esempio ( ne ho a decine, e alcuni con esiti anche superiori ) tratto da una scansione con una mia Rete, dove i primi classificati per regressione dimostrano come al solito, e ormai da anni una certa attendibilità.

in questo caso le seconde posizioni. vedi foto.

BARI - Fine Data Range Analizzato 29/06/2023

osserviamo nella foto i 2°i classificati :

67-22-15-25-24

Esito 15 24 67 al 1° C.

Allegati

Halmun

Advanced Member >PLATINUM<

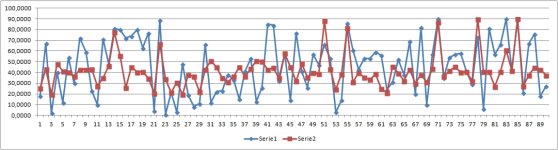

l'importanza dei RANGE virtuali rispetto al RANGE normale ( le normali 5 colonne dei 5 estratti )

a pari configurazione e cicli d'apprendimento è palese la differenza quando si da un'occhiata alla Regressione, qui nell'esempio decisamente a vantaggio di Determinati RANGE creati ad Hoc per ottenere il Minimo errore.

ovvio che la stessa cosa la si può ottenere anche con la Funzione Regressione di Excel senza dover ricorrere ad un software neurale, ma non è la stessa cosa. una regressione di tipo Neurale, quindi condizionata da nodi, strati nascosti, coefficiente di regressione ecc. ecc. al confronto restituisce una differenza Abissale.

Allineamento Target-Output : Confronto Somma degli Errori:

Scan con Range Normale = 1722,5311

Scan con Range Virtuale = 129,1027

a pari configurazione e cicli d'apprendimento è palese la differenza quando si da un'occhiata alla Regressione, qui nell'esempio decisamente a vantaggio di Determinati RANGE creati ad Hoc per ottenere il Minimo errore.

ovvio che la stessa cosa la si può ottenere anche con la Funzione Regressione di Excel senza dover ricorrere ad un software neurale, ma non è la stessa cosa. una regressione di tipo Neurale, quindi condizionata da nodi, strati nascosti, coefficiente di regressione ecc. ecc. al confronto restituisce una differenza Abissale.

Allineamento Target-Output : Confronto Somma degli Errori:

Scan con Range Normale = 1722,5311

Scan con Range Virtuale = 129,1027

Allegati

Ultima modifica:

Halmun

Advanced Member >PLATINUM<

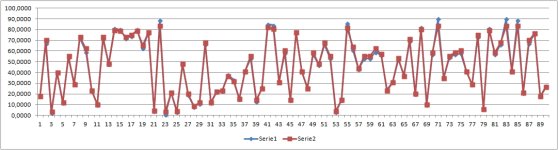

Reti neurali x Clustering ( es: EXCEL-TOOL : NNCLUST di Angshuman Saha )

da sempre sono stato d'accordo con quanto riportato nelle foto ( il passo dell'articolo non è mio ) e stessa cosa vale x gli errori fra Target e Output, ma per quanto l'errore medio sia considerato il punto più importante, e di conseguenza tutti quei valori-errore che si avvicinano di più all'errore medio, la mia personale esperienza mi ha insegnato che i Punti d'Attrazione sono prevalentemente 3 .

1° - valori numerici ( ambate ) associati o più vicini all'errore Minimo

2° - valori numerici ( ambate ) associati o più vicini all'errore Medio

3° - valori numerici ( ambate ) associati o più vicini all'errore Massimo

da sempre sono stato d'accordo con quanto riportato nelle foto ( il passo dell'articolo non è mio ) e stessa cosa vale x gli errori fra Target e Output, ma per quanto l'errore medio sia considerato il punto più importante, e di conseguenza tutti quei valori-errore che si avvicinano di più all'errore medio, la mia personale esperienza mi ha insegnato che i Punti d'Attrazione sono prevalentemente 3 .

1° - valori numerici ( ambate ) associati o più vicini all'errore Minimo

2° - valori numerici ( ambate ) associati o più vicini all'errore Medio

3° - valori numerici ( ambate ) associati o più vicini all'errore Massimo

Allegati

Ultima modifica:

Halmun

Advanced Member >PLATINUM<

x Claudio8

ma non ti avevo mandato tempo fa alcuni software da utilizzare secondo tuoi personali accorgimenti?

compreso PYTHIA e GMDH che almeno sono RETI VERAMENTE STABILI.

e con IL termine STABILE intendo dire che al ripetersi ex-novo della Scansione la rete ti deve restituire gli stessi risultati.

infatti x pura curiosità ho provato la rete che state testando e a mio parere fate prima a buttarla via. ogni volta che chiudi il software e lo riapri con gli stessi parametri d'ingresso e accorgimenti vari ti restituisce valori completamente diversi dalla scansione precedente.

ora, a parte il fatto che anche così potrebbe restituirvi prima o poi esiti apprezzabili, tanto varrebbe a questo punto chiedere i numeri alla signora Gina del 4° piano, di norma anche Lei ci azzecca con i numeri che le danno in sogno.

scherzi a parte: ricordati cmq. che PYTHIA, x quanto STABILE, risente delle differenze fra le varie CPU dei PC. come ricordo di aver dimostrato quando la testammo sul tuo PC confrontandolo col mio .......... i miei risultati differivano dai tuoi, ma in entrambi i casi risultarono attendibili.

se poi vuoi tagliare la testa al toro affidati a GMDH ..... non ha certo questi problemi, e personalmente la considero straordinaria.

IDEM x NNPRED .... i suoi 100 risultati progressivi estrapolati dalla sezione Profil modificabile a piacimento sono i + attendibili nei primi e negli ultimi valori della progressione. quindi lascia stare la regressione nella sezione nascosta Process, gli scarti-errori sono enormi.

ma non ti avevo mandato tempo fa alcuni software da utilizzare secondo tuoi personali accorgimenti?

compreso PYTHIA e GMDH che almeno sono RETI VERAMENTE STABILI.

e con IL termine STABILE intendo dire che al ripetersi ex-novo della Scansione la rete ti deve restituire gli stessi risultati.

infatti x pura curiosità ho provato la rete che state testando e a mio parere fate prima a buttarla via. ogni volta che chiudi il software e lo riapri con gli stessi parametri d'ingresso e accorgimenti vari ti restituisce valori completamente diversi dalla scansione precedente.

ora, a parte il fatto che anche così potrebbe restituirvi prima o poi esiti apprezzabili, tanto varrebbe a questo punto chiedere i numeri alla signora Gina del 4° piano, di norma anche Lei ci azzecca con i numeri che le danno in sogno.

scherzi a parte: ricordati cmq. che PYTHIA, x quanto STABILE, risente delle differenze fra le varie CPU dei PC. come ricordo di aver dimostrato quando la testammo sul tuo PC confrontandolo col mio .......... i miei risultati differivano dai tuoi, ma in entrambi i casi risultarono attendibili.

se poi vuoi tagliare la testa al toro affidati a GMDH ..... non ha certo questi problemi, e personalmente la considero straordinaria.

IDEM x NNPRED .... i suoi 100 risultati progressivi estrapolati dalla sezione Profil modificabile a piacimento sono i + attendibili nei primi e negli ultimi valori della progressione. quindi lascia stare la regressione nella sezione nascosta Process, gli scarti-errori sono enormi.

Halmun

Advanced Member >PLATINUM<

NNPRED? a parer mio decisamente migliore.Buon giorno Mira

Queste reti hanno bisogno di molti test per il loro settaggio e comunque come dice l'autore stesso :

" Non ci sono prove matematiche (secondo le mie informazioni) le reti neurali ti aiuteranno a vincere alla lotteria o ti daranno scelte migliori rispetto ad altre tecniche. Anche se questo strumento può darti dei risultati sorprendentemente buoni di tanto in tanto..."

Per quanto ne sappia io, un conoscitore di reti neurali è @Halmun.

Comunque a prima vista non mi pare molto diverso dal vecchio NNpred in excel ( traducibile in italiano) che con qualche accorgimento in VBA è forse maggiormente versatile rispetto a questo programma.

Spero che qualcuno ti sappia dare migliori notizie.

Saluti

Halmun

Advanced Member >PLATINUM<

TEST FATTO AL VOLO CON NNPRED - SCAN SU RANGE-NUMERI DA 46 A 90 - FINE DATA RANGE ANALIZZATO 20/06/2023

SEGUONO I 100 RISULTATI X COLONNA TRATTE DALLE 4 PROFIL + MEDIA FINALE

DIAMO ORA UN'OCCHIATA AI PRIMI VALORI 67-68-59-54-62

BARI : ESITI: .............. AMBO 59-68 al 4° C. + AMBO 67-62 AL 5° C.

( inutile sottolineare che stiamo aspettando la coppia 53-54 con ambata primaria 54 )

SEGUONO I 100 RISULTATI X COLONNA TRATTE DALLE 4 PROFIL + MEDIA FINALE

DIAMO ORA UN'OCCHIATA AI PRIMI VALORI 67-68-59-54-62

BARI : ESITI: .............. AMBO 59-68 al 4° C. + AMBO 67-62 AL 5° C.

( inutile sottolineare che stiamo aspettando la coppia 53-54 con ambata primaria 54 )

| A | B | C | D | MD |

| 66,542905868610 | 67,781570804853 | 58,692563008850 | 53,824535781106 | 61,710393865855 |

| 66,586071889851 | 67,802581500292 | 58,851091034468 | 53,937500564625 | 61,794311247309 |

| 66,629240347341 | 67,823587673016 | 59,012222793471 | 54,055506648311 | 61,880139365535 |

| 66,672409317929 | 67,844589239367 | 59,175946454006 | 54,178765831578 | 61,967927710720 |

| 66,715578643238 | 67,865586115801 | 59,342253739491 | 54,307498428322 | 62,057729231713 |

| 66,758748165386 | 67,886578218891 | 59,511133410082 | 54,441929977907 | 62,149597443066 |

| 66,801915962626 | 67,907565465322 | 59,682564116427 | 54,582287004603 | 62,243583137245 |

| 66,845081878221 | 67,928547771900 | 59,856528125446 | 54,728804667993 | 62,339740610890 |

| 66,888245755982 | 67,949525055549 | 60,033004500970 | 54,881716265129 | 62,438122894407 |

| 66,931405676280 | 67,970497233313 | 60,211961671011 | 55,041261110204 | 62,538781422702 |

| 66,974561484452 | 67,991464222358 | 60,393371797616 | 55,207679968126 | 62,641769368138 |

| 67,017713026439 | 68,012425939974 | 60,577203666912 | 55,381209309112 | 62,747137985609 |

| 67,060858385434 | 68,033382803151 | 60,763414987389 | 55,562088652659 | 62,854936207158 |

| 67,103997409281 | 68,054333730148 | 60,951967389748 | 55,750555057956 | 62,965213396783 |

| 67,147129358904 | 68,075279138337 | 61,142816424152 | 55,946836304303 | 63,078015306424 |

| 67,190254083750 | 68,096218945515 | 61,335916688079 | 56,151158894811 | 63,193387153039 |

| 67,233369671865 | 68,117153069610 | 61,531211278011 | 56,363741504771 | 63,311368881064 |

| 67,276475975097 | 68,138081428680 | 61,728647592506 | 56,584787011742 | 63,431998002006 |

| 67,319572846019 | 68,159003940919 | 61,928169600936 | 56,814491266257 | 63,555309413533 |

| 67,362658377122 | 68,179920524651 | 62,129709599840 | 57,053035468128 | 63,681330992436 |

| 67,405732423748 | 68,200831098341 | 62,333204578764 | 57,300577059423 | 63,810086290069 |

| 67,448794842008 | 68,221735580589 | 62,538588253285 | 57,557261718185 | 63,941595098517 |

| 67,491843729524 | 68,242633890131 | 62,745782631786 | 57,823203417078 | 64,075865917130 |

| 67,534878945541 | 68,263525945848 | 62,954714899300 | 58,098496979216 | 64,212904192476 |

| 67,577900350120 | 68,284411666758 | 63,165309236185 | 58,383208920084 | 64,352707543286 |

| 67,620906046687 | 68,305290972024 | 63,377478223353 | 58,677366850933 | 64,495260523249 |

| 67,663895898793 | 68,326163780952 | 63,591140189724 | 58,980971527960 | 64,640542849357 |

| 67,706869770850 | 68,347030012993 | 63,806210839480 | 59,293987172451 | 64,788524448943 |

| 67,749825772755 | 68,367889587746 | 64,022594524742 | 59,616330491628 | 64,939160094218 |

| 67,792763772758 | 68,388742424957 | 64,240201993049 | 59,947884724006 | 65,092398228693 |

| 67,835683640015 | 68,409588444520 | 64,458941847440 | 60,288489910215 | 65,248175960548 |

| 67,878583491547 | 68,430427814863 | 64,678711716004 | 60,637932079896 | 65,406413775577 |

| 67,921463200692 | 68,451259959337 | 64,899416327622 | 60,995962926840 | 65,567025603623 |

| 67,964322641734 | 68,472085046758 | 65,120958830193 | 61,362274861163 | 65,729910344962 |

| 68,007159939457 | 68,492902997630 | 65,343231886606 | 61,736522343222 | 65,894954291729 |

| 68,049974972667 | 68,513713732613 | 65,566136000177 | 62,118313226874 | 66,062034483083 |

| 68,092767621147 | 68,534517172525 | 65,789570717330 | 62,507199452456 | 66,231013740865 |

| 68,135536018080 | 68,555313238342 | 66,013425679398 | 62,902698450577 | 66,401743346599 |

| 68,178280048102 | 68,576101851199 | 66,237599114230 | 63,304285620276 | 66,574066658452 |

| 68,220999015032 | 68,596882932393 | 66,461985892550 | 63,711386382702 | 66,747813555669 |

| 68,263692806553 | 68,617656403380 | 66,686483854877 | 64,123400417892 | 66,922808370676 |

| 68,306359568003 | 68,638422185783 | 66,910981802674 | 64,539695297024 | 67,098864713371 |

| 68,348999192343 | 68,659180201385 | 67,135378076828 | 64,959603498365 | 67,275790242230 |

| 68,391611573590 | 68,679930619453 | 67,359571598395 | 65,382430610213 | 67,453386100413 |

| 68,434194866898 | 68,700672867381 | 67,583452930470 | 65,807486322168 | 67,631451746729 |

| 68,476748971872 | 68,721407114862 | 67,806922820424 | 66,234045845646 | 67,809781188201 |

| 68,519273789201 | 68,742133284351 | 68,029883219795 | 66,661377392972 | 67,988166921580 |

| 68,561767484441 | 68,762851298475 | 68,252228398300 | 67,088770198945 | 68,166404345041 |

| 68,604229964171 | 68,783561080029 | 68,473863365263 | 67,515495692165 | 68,344287525407 |

| 68,646661136076 | 68,804262551985 | 68,694694899075 | 67,940835301504 | 68,521613472160 |

| 68,689059176684 | 68,824955637484 | 68,914622741664 | 68,364107838085 | 68,698186348479 |

| 68,731423999864 | 68,845640259846 | 69,133557818755 | 68,784630230440 | 68,873813077226 |

| 68,773755520613 | 68,866316342565 | 69,351413310073 | 69,201744489859 | 69,048307415778 |

| 68,816051926985 | 68,886983809315 | 69,568095952091 | 69,614843375695 | 69,221493766022 |

| 68,858313140444 | 68,907642583946 | 69,783523982749 | 70,023330668942 | 69,393202594020 |

| 68,900539083597 | 68,928292590488 | 69,997618283899 | 70,426646381080 | 69,563274084766 |

| 68,942727956564 | 68,948933999161 | 70,210293819485 | 70,824289969351 | 69,731561436140 |

| 68,984879688693 | 68,969566242235 | 70,421477237598 | 71,215780389363 | 69,897925889472 |

| 69,026994210492 | 68,990189490400 | 70,631098116519 | 71,600679015768 | 70,062240208295 |

| 69,069069734668 | 69,010803668416 | 70,839080564495 | 71,978610096292 | 70,224391015968 |

| 69,111106198730 | 69,031408701229 | 71,045360420090 | 72,349221083546 | 70,384274100899 |

| 69,153103541362 | 69,052004513970 | 71,249876632528 | 72,712203122730 | 70,541796952648 |

| 69,195059988360 | 69,072591031960 | 71,452563047750 | 73,067308809132 | 70,696880719301 |

| 69,236975485661 | 69,093168180705 | 71,653365156654 | 73,414313459708 | 70,849455570682 |

| 69,278849410180 | 69,113735885902 | 71,852228943179 | 73,753039116095 | 70,999463338839 |

| 69,320681711901 | 69,134294073439 | 72,049106358876 | 74,083340917341 | 71,146855765389 |

| 69,362470634827 | 69,154842669396 | 72,243944618507 | 74,405128000889 | 71,291596480905 |

| 69,404216136521 | 69,175381600045 | 72,436702281999 | 74,718327074827 | 71,433656773348 |

| 69,445918175726 | 69,195911036519 | 72,627341058696 | 75,022898058468 | 71,573017082352 |

| 69,487575010646 | 69,216430416024 | 72,815818112828 | 75,318846941590 | 71,709667620272 |

| 69,529186607831 | 69,236939910201 | 73,002101609030 | 75,606191720338 | 71,843604961850 |

| 69,570752935012 | 69,257439446104 | 73,186162739974 | 75,884976510741 | 71,974832907958 |

| 69,612272265037 | 69,277928950982 | 73,367968284596 | 76,155282988800 | 72,103363122354 |

| 69,653744573660 | 69,298408352285 | 73,547495594418 | 76,417199035288 | 72,229211888913 |

| 69,695169837815 | 69,318877577663 | 73,724724865229 | 76,670831602564 | 72,352400970818 |

| 69,736546345419 | 69,339336554963 | 73,899631961850 | 76,916317047638 | 72,472957977467 |

| 69,777874081632 | 69,359785212239 | 74,072202829671 | 77,153792640780 | 72,590913691080 |

| 69,819153032788 | 69,380223477743 | 74,242426027548 | 77,383408388375 | 72,706302731614 |

| 69,860381502281 | 69,400651279934 | 74,410285829714 | 77,605336477286 | 72,819163772304 |

| 69,901559484867 | 69,421068547473 | 74,575776053329 | 77,819745640894 | 72,929537431641 |

| 69,942686976460 | 69,441475209229 | 74,738892866157 | 78,026812069723 | 73,037466780392 |

| 69,983762296323 | 69,461871437349 | 74,899628172998 | 78,226728105699 | 73,142997503092 |

| 70,024785448975 | 69,482256674837 | 75,057982855704 | 78,419679341877 | 73,246176080348 |

| 70,065756440085 | 69,502631094384 | 75,213959865563 | 78,605854700621 | 73,347050525163 |

| 70,106673605149 | 69,522994625690 | 75,367557898513 | 78,785454459697 | 73,445670147262 |

| 70,147536958612 | 69,543347198663 | 75,518784048975 | 78,958669888946 | 73,542084523799 |

| 70,188346516047 | 69,563688743423 | 75,667647193352 | 79,125692544529 | 73,636343749338 |

| 70,229100629536 | 69,584019190300 | 75,814151955375 | 79,286721674489 | 73,728498362425 |

| 70,269799323590 | 69,604338469840 | 75,958310779261 | 79,441946159518 | 73,818598683052 |

| 70,310442070495 | 69,624646512799 | 76,100135691096 | 79,591555603645 | 73,906694969509 |

| 70,351028899247 | 69,644943250150 | 76,239642134895 | 79,735734417096 | 73,992837175347 |

| 70,391558184553 | 69,665228613080 | 76,376841310313 | 79,874671284361 | 74,077074848077 |

| 70,432029964540 | 69,685502532993 | 76,511751486140 | 80,008543801242 | 74,159456946229 |

| 70,472444278413 | 69,705765182986 | 76,644392070213 | 80,137526065921 | 74,240031899383 |

| 70,512799518204 | 69,726016011804 | 76,774778242613 | 80,261794746247 | 74,318847129717 |

| 70,553095732384 | 69,746255193118 | 76,902931713980 | 80,381515469461 | 74,395949527236 |

| 70,593332970467 | 69,766482659205 | 77,028875086064 | 80,496849736997 | 74,471385113183 |

| 70,633509642100 | 69,786698342560 | 77,152626762177 | 80,607960460220 | 74,545198801764 |

| 70,673625806186 | 69,806902175902 | 77,274211165287 | 80,714999892566 | 74,617434759985 |

| 70,713681522644 | 69,827094092168 | 77,393653383873 | 80,818115905836 | 74,688136226130 |

Allegati

Halmun

Advanced Member >PLATINUM<

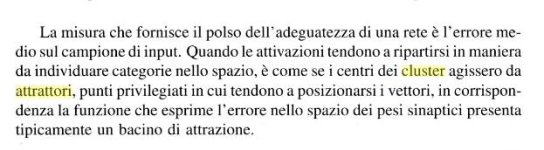

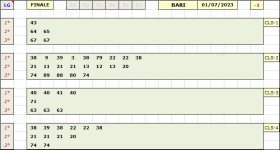

BARI - Fine Data Range Analizzato 01/07/2023non conosco la rete che state utilizzando, io ne uso altre, prevalentemente per regressione, e sinceramente dopo vari anni di utilizzo non posso lamentarmi. ad una rete neurale non interessano ritardi, frequenze, scompensi ecc. ecc. a meno che non si analizzino RANGE preparati per casi in questione. io mi sono creato fogli excel di conversione-dati dei risultati delle reti che utilizzo, e successivamente tramite filtri-excel e quant'altro traggo le mie personali deduzioni.

ma come ogni strategia anche i risultati di una rete vanno seguiti passo-passo, e solo attraverso l'osservazione dei periodi-momenti positivi si deve decidere se attaccare il gioco o meno, e lungi dal far polemiche sterili, ma chi dice che non servono a nulla o che non aiutino a raggiungere determinati risultati si sbaglia di grosso, o perlomeno non sa di cosa parla.

le reti analizzano numeri, che siano valori mensili o annuali dei guadagni di una attività, o andamenti statistici di previsione per le vendite, o l'andamento statistico o meno di determinati gruppi numerici al LOTTO non vi è alcuna differenza.

di seguito l'ultimo recente esempio ( ne ho a decine, e alcuni con esiti anche superiori ) tratto da una scansione con una mia Rete, dove i primi classificati per regressione dimostrano come al solito, e ormai da anni una certa attendibilità.

in questo caso le seconde posizioni. vedi foto.

BARI - Fine Data Range Analizzato 29/06/2023

osserviamo nella foto i 2°i classificati :

67-22-15-25-24

Esito 15 24 67 al 1° C.

Esito 11 12 al 1° C.

non l'ho giocata causa attenzione su altri N°i ma vi invito ad osservare ancora i 2°i classificati, dove la stringa Numerica composta da 8 numeri rilevati sulle 4 classifiche ( secondo me troppi ) ha cmq. restituito un ambo al 1° C. esattamente come la volta precedente dove avevamo una stringa di soli 5 Numeri.

Allegati

forerunner

Advanced Member >GOLD<

Ciao Halmun,BARI - Fine Data Range Analizzato 01/07/2023

Esito 11 12 al 1° C.

non l'ho giocata causa attenzione su altri N°i ma vi invito ad osservare ancora i 2°i classificati, dove la stringa Numerica composta da 8 numeri rilevati sulle 4 classifiche ( secondo me troppi ) ha cmq. restituito un ambo al 1° C. esattamente come la volta precedente dove avevamo una stringa di soli 5 Numeri.

innanzitutto complimenti per le tue analisi. Inoltre, se non ti dispiace ti chiedo di mandarmi il giusto link per scaricare NNPRED.

Saluti

forerunner

Ultima estrazione Lotto

-

Estrazione del lotto

giovedì 26 febbraio 2026Bari8645225680Cagliari2546601402Firenze8630430362Genova0783576014Milano3926635465Napoli1359181584Palermo8178588782Roma6936513371Torino1954342625Venezia3723054426Nazionale0728896327Estrazione Simbolotto

Cagliari

3831222939

3831222939